Le début des années 2000 a été marqué par de tels progrès en cosmologie que l’on a pu parler de son entrée dans l’ère de la précision et de la constitution de ce qui a été appelé le modèle de concordance. Mais on assiste maintenant à des discordances selon les méthodes entre les diverses estimations de l’accélération de l’expansion du cosmos observable, peut-être causée par l’énergie noire. Sommes-nous à la veille d’une révolution en cosmologie ?

au sommaire

On sait depuis presque 20 ans que l'expansion de l'Univers observable est en cours d'accélération depuis quelques milliards d'années alors que les premiers modèles cosmologiques envisagés à partir de la découverte du rayonnement fossile et, pour faire simple, à la fin des années 1970 en se basant sur d'autres observations et mesures en astrophysique à cette époque, prévoyaient une décélération de l'expansion après une phase de Big BangBig Bang chaude du CosmosCosmos primordial.

Une image aide à comprendre de quoi il s'agit. L'évolution de l'expansion sous l'effet de la gravité du contenu du cosmos observable devait être analogue à celle d'un caillou lancé à la main à la verticale sur Terre, sous l'effet de la gravité en fin de trajectoire, décélérant avant de retomber. Mais dans le cas du Cosmos, le futur de cette expansion n'était pas forcément tel qu'elle s'inverse et devienne une contraction menant à un Big Crunch. La question d'une cosmologie cyclique avec un avant le Big Bang reste d'ailleurs largement ouverte. Or, l'expansion s'accélère.

On ne sait pas à ce jour ce qui cause cette accélération (c'est uniquement pour la mise en évidence de cette accélération que ses découvreurs Saul Perlmutter, Brian Schmidt et Adam Riess ont reçu le prix Nobel de PhysiquePhysique, sans rien supposer sur son origine). Il pourrait s'agir de ce que l'on appelle l'énergie noireénergie noire, terme sur lequel on reviendra, mais pour certains aussi, très minoritaires, du fait que l'Univers observable n'est pas aussi homogène qu'on le pense à suffisamment grande échelle.

Dans le premier cas, il faut une nouvelle physique et dans le second, aucune.

Présentation par Françoise Combes de son cours 2016-2017 : « Énergie noire et modèles d'univers ». © Collège de France

Un zoo de modèles cosmologiques relativistes

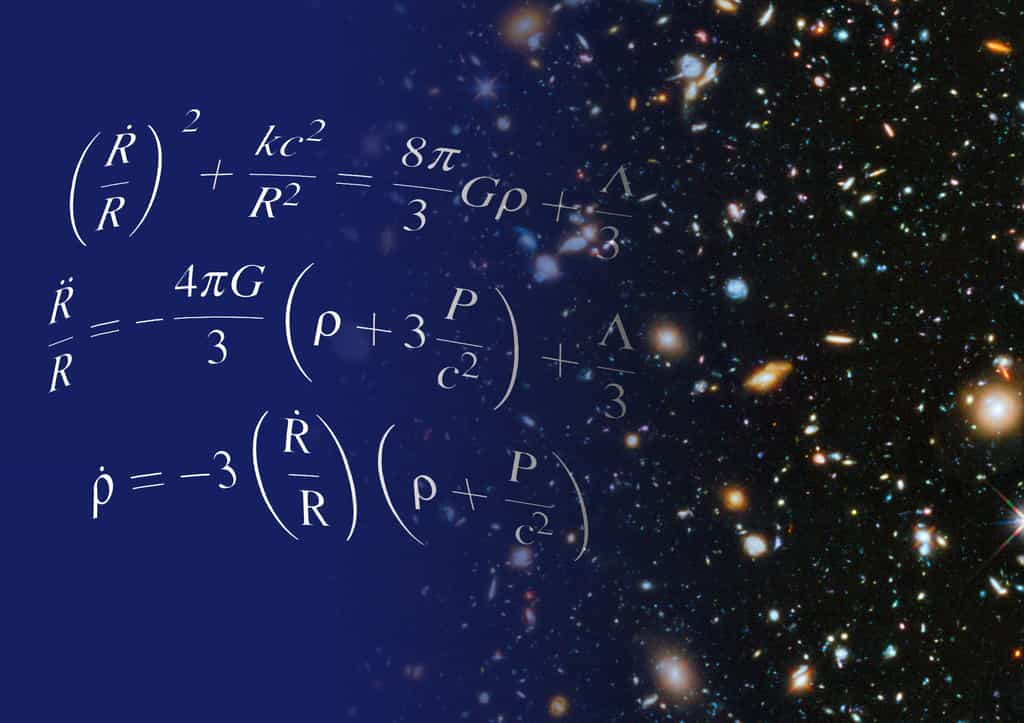

Par contre, dans les deux cas, pour rendre compte de cette accélération, il s'introduit dans les équationséquations d'EinsteinEinstein une constante, la fameuse constante cosmologiqueconstante cosmologique que le génial découvreur de la théorie de la relativité généralerelativité générale a été le premier à considérer en 1917 lorsqu'il a proposé le premier modèle cosmologique relativiste (l'idée d'un espace courbe clos en trois dimensions, décrit par la géométrie de Riemann et pertinent pour le monde physique, est antérieure à Einstein, comme le montre par exemple la lecture de plusieurs passages d’un texte de Ernst Mach en 1903. Or, Einstein était un grand lecteur de Mach).

Il y aurait beaucoup à dire sur les raisons exactes qui ont poussé Einstein à introduire cette constante, notée Λ, dont l'origine peut s'interpréter de diverses manières.

Ce qui est sûr, c'est qu'elle lui a permis de construire un Univers de taille finie et à la géométrie statique, sans début ni fin dans le temps, en accord avec les idées que l'on se faisait du cosmos depuis AristoteAristote sur la base d'une fixité apparente des étoilesétoiles.

Ce qui est sûr également, c'est que Λ se comporte comme une densité d'énergie qui ne se dilue pas dans un univers en expansion contrairement à la densité de matièrematière ou de rayonnement, qu'on peut la faire dériver naïvement et au moins formellement de l'énergie du point zéropoint zéro, qui semble au premier abord incontournable et qui est issue d'une description quantique des oscillations des champs - qu'ils soient électromagnétique, de gravitationgravitation ou de matière comme le champ de Dirac des électronsélectrons et des quarksquarks. Cette densité peut se comporter comme une pressionpression attractive ou répulsive.

Par son caractère discret et difficile à mettre en évidence, et en raison de son comportement paradoxal échappant à la dilution, on a donc introduit le terme d'énergie noire pour désigner cette densité d'énergie exotiqueexotique qui peut s'identifier avec Λ, mais dont on aimerait retrouver par le calcul la valeur observée dans l'Univers.

Si la constante d'Einstein est bien une mesure de la densité d'énergie de ce que l'on appelle le vide quantique avec en particulier son énergie du point zéro, cela pose bien des problèmes car elle devrait être formidable, des milliards et des milliards de milliards de milliards de fois plus importante que ce que l'on mesure en fait, et même bien plus car le désaccord est de l'ordre d'un facteur 10120 .

Mais on ne sait pas vraiment comment effacer cette contradiction entre théorie et expérience, même si plusieurs tentatives ont été faites.

On parle d'ailleurs à ce sujet de « la pire prédiction jamais faite par la physique théorique ». Comme Futura l'expliquait dans un dossier consacré à l'énergie noire, l'énigme est ancienne puisqu'elle avait déjà été mentionnée par Wolfgang PauliWolfgang Pauli au début des années 1920. Ses calculs montraient que si l'on prenait en compte cette énergie de point zéro, le rayon de l'Univers du modèle d'Einstein serait de 31 kilomètres !

Λ peut-être reliée à une autre constante, celle de la mythique loi de Hubble-Lemaître qui permet de relier le décalage spectral vers le rouge des galaxiesgalaxies à leurs distances de la Voie lactéeVoie lactée (ce décalage n'est en réalité pas un effet Dopplereffet Doppler même si on peut souvent faire comme si). En fait, cette constante de Hubbleconstante de Hubble-Lemaître varie selon une loi dans le temps dépendant du modèle cosmologique considéré, par exemple un univers fini et sphérique, avec ou sans constante cosmologique, etc.

Or, ces dernières années, il y a un désaccord de plus en plus dérangeant, au fur et à mesure que les mesures se font de plus en plus précises et que la taille des barres d'erreurs diminue, en ce qui concerne les estimations de la valeur actuelle de la constante de Hubble-Lemaître que l'on note H0. Les diverses méthodes utilisées pour l'estimer donnent des résultats parfois si peu compatibles que certains chercheurs n'hésitent plus à parler non pas de tension entre les mesures mais bien d'une crise de la cosmologiecosmologie du modèle standardmodèle standard.

Le modèle ΛCDM, CDM étant l'acronyme de Cold Dark Matter, en anglais, c'est-à-dire matière noirematière noire froide, suppose une constante Λ qui ne varie pas dans le temps et l'espace, à la précision des mesures actuelles, et un ensemble de six paramètres dont toutes les déterminations par des méthodes indépendantes concordent au point que l'on peut difficilement changer de modèle sans perdre en adéquation avec l'ensemble des mesures.

L'Univers est alors considéré comme plat, isotropeisotrope et sans rotation, toujours à la limite des mesures actuelles. Mais sa topologie est encore inconnue (nous pourrions vivre dans l'équivalent d'un tore).

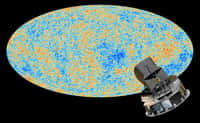

Précisons qu'il existe des modèles de cosmologies relativistes anisotropesanisotropes (voir la classification de Bianchi) mais homogènes à suffisamment grande échelle - comme dans le cas du ΛCDM - qui pourraient décrire une phase primitive du Cosmos observable, mais qui évoluent en devenant plus ou moins rapidement isotropes. Précisons que l'argument le plus important pour considérer l'Univers observable comme homogène au moins juste après le Big Bang est fourni par le rayonnement fossile. Viennent ensuite les observations des quasarsquasars et des grandes structures regroupant les galaxies et amas de galaxiesamas de galaxies.

Une présentation simple des méthodes combinées pour mesurer les distances dans l'Univers, de celle de la parallaxe à celle de Hubble pour les supernovae SN Ia. © Unisciel

Un modèle de concordance qui est devenu discordant

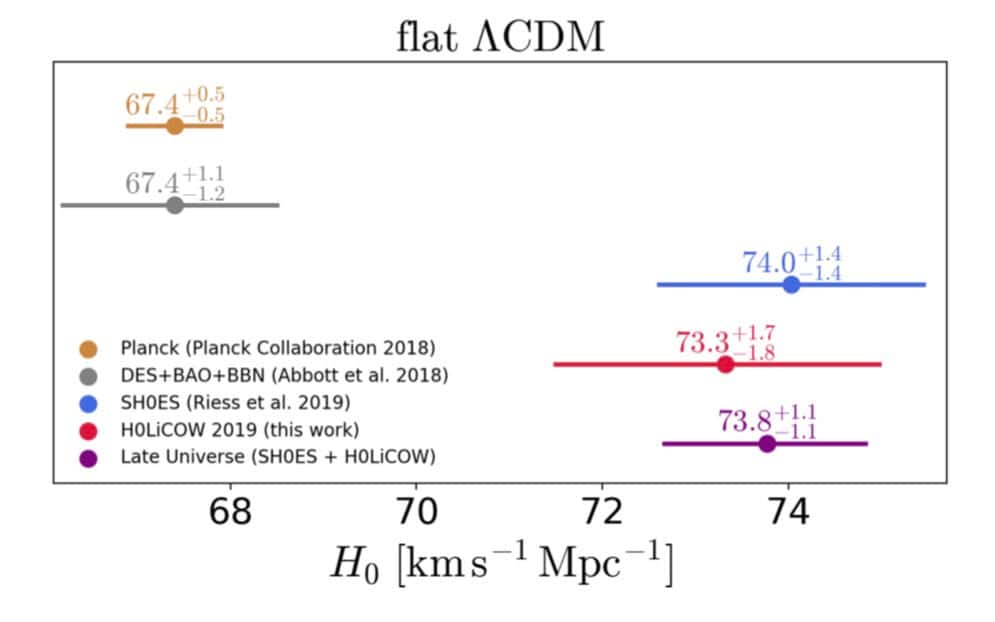

En ce qui concerne la possible crise actuelle de la cosmologie, tout a commencé avec la comparaison des estimations de H0 tirées de l'analyse des données concernant le rayonnement fossile, collectées par la mission PlanckPlanck d'une part et de l'analyse de celles issues des supernovaesupernovae SNSN Ia d'autre part. Ces explosions stellaires conduisent à H0=73 km/s/Mpc (kilomètres par seconde par mégaparsec) environ alors que le rayonnement fossile livre comme valeur environ 67 km/s/Mpc. Pas complètement indépendamment de l'étude du rayonnement fossile, la détermination de ce que l'on appelle les oscillations acoustiques des baryons (BAO pour baryon acoustic oscillations, en anglais) livre également une valeur similaire à celle de Planck.

Il pourrait s'agir dans un cas d'erreurs de mesures suffisamment subtiles pour avoir échappé jusqu'à présent à la sagacité et à la rigueur des membres des équipes d'astronomesastronomes utilisant chacune une de ces méthodes. On se souvient qu'il avait fallu un certain temps pour que l'affaire des neutrinos transluminiques que l’on pensait avoir découverts au Cern « se dégonfle ». Plus récemment, ce fut le cas avec la découverte des modes B de l’inflation qui a également été invalidée.

Mais d'autres techniques d'évaluation se sont ajoutées ces dernières années, confirmant le problème. Futura voulait revenir longuement sur ces questions peu après une conférence internationale sur le sujet qui s’est tenue à la mi-juillet 2019 au célèbre Kavli Institute for Theoretical Physics à Santa Barbara (un bilan se trouve aussi dans un article sur arXiv) mais en raison de la pandémiepandémie et d'autres événements, un article très complet a été différé à plusieurs reprises jusqu'à aujourd'hui.

Toutefois, à l'occasion de l'anniversaire des 20 ans de Futura, plusieurs des personnalités qui nous soutiennent se sont vues donner la possibilité de proposer un éditorial, en l'occurrence plusieurs articles sur des thèmes précis. Françoise Combes, astrophysicienne au Laboratoire d'études du rayonnement et de la matière en astrophysique et atmosphèresatmosphères, membre de l'Académie des Sciences, titulaire depuis 2014 de la chaire Galaxies et cosmologie au Collège de France et lauréate de la médaille d'or du CNRS 2020, nous a demandé un article sur cette énigme qui rend actuellement perplexes les cosmologistes.

C'est donc l'occasion de commencer à revenir sur ce sujet tout en se limitant pour le moment à certains de ses aspects les plus essentiels. Une partie des nombreux articles en rapport avec ces questions déjà publiés par Futura sera utilisée pour cela.

En cosmologie, on parle de l'échelle des distances cosmiques pour désigner un ensemble de méthodes qui prennent appui les unes sur les autres pour déterminer de proche en proche les distances des astres dans le cosmos observable. Tout commence avec des mesures de parallaxe dans le Système solaire, c'est-à-dire des angles que fait une étoile proche sur la voûte céleste à deux périodes de l'année. La géométrie du triangle permet alors de déduire une distance si les angles sont assez grands pour être mesurables. © Hubble, ESA

La problématique de l'échelle des distances cosmiques

Quelques rappels pour comprendre de quoi il en retourne et qui donnent des explications complémentaires concernant les deux vidéos ci-dessus, qui illustrent ce qui est expliqué ci-après.

Les Céphéides sont des étoiles variablesétoiles variables particulières qui voient leur luminositéluminosité changer au cours du temps avec une période donnée. C'est en 1912, en étudiant les Céphéides du Petit Nuage de MagellanPetit Nuage de Magellan, que Henrietta LeavittHenrietta Leavitt découvrit que cette période était corrélée à leur magnitude apparentemagnitude apparente moyenne. Plus elles sont lumineuses et plus lentement elles varient. On pouvait donc espérer déduire la luminosité intrinsèque d'une céphéide en mesurant sa période. La méthode a été étalonnée grâce aux céphéides proches dont la distance pouvait être évaluée par la méthode de la parallaxeparallaxe qui permet d'estimer les distances des étoiles les plus proches dans la Voie lactée. Il était dès lors possible de déduire la distance de céphéides plus lointaines directement de leur rythme de variation d'éclat. En effet, plus une étoile est loin, moins elle apparaît lumineuse mais si l'on connaît sa luminosité intrinsèque, on peut estimer sa distance.

Les Céphéides sont ainsi devenues des sortes de chandelles standardchandelles standard permettant d'évaluer la distance séparant la Voie lactée des galaxies, là aussi les plus proches, comme Andromède ou le Grand Nuage de MagellanGrand Nuage de Magellan. Edwin HubbleEdwin Hubble se servit de la relation de Henrietta Leavitt, d'abord pour découvrir l'expansion de l'Univers et ensuite étalonner la loi de Hubble-Lemaître reliant la distance d'une galaxie avec son décalage spectral.

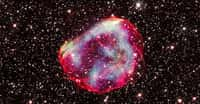

Pour mesurer des distances encore plus lointaines dans l'Univers lointain, il est possible d'utiliser un autre type d'étoiles qui ne sont pas exactement des chandelles standard mais qui peuvent servir de bons indicateurs de distance. Ce sont les supernovae SN Ia.

Ces astresastres résultent de l'explosion de naines blanchesnaines blanches dans un système binairesystème binaire. La luminosité d'une SN Ia ne peut pas s'écarter beaucoup d'une certaine valeur moyenne, et comme elle peut représenter celle de centaines de milliards d'étoiles, on peut les voir de loin. En se servant des Céphéides, on peut étalonner une relation donnant la luminosité apparente d'une SN Ia avec sa distance. Connaissant son décalage spectral vers le rouge, on peut alors relier sa distance à ce décalage et, par la loi de Hubbleloi de Hubble-Lemaître, à la vitessevitesse d'expansion de l'Univers à une date donnée de son histoire (puisque observer loin, c'est observer tôt).

C'est en dressant la courbe reliant le décalage spectral des SN Ia avec leur luminosité apparente que Riess, Perlmutter et leurs collègues ont découvert l'expansion accélérée de l'Universexpansion accélérée de l'Univers.

Malheureusement, l'étalonnage des relations luminosité-distance des Céphéides avec la méthode de la parallaxe n'est pas exempt d'erreurs et celui des SN Ia non plus. Ces erreurs s'accumulent donc sur ce que l'on appelle l'échelle des distances cosmiques en raison de ce que les scientifiques appellent la loi de la propagation des erreurs, de sorte que pendant longtemps la fameuse constante de Hubble mesurant l'expansion de l'Univers n'était connue qu'avec de larges incertitudes, puis de l'ordre de 10 % en 2001, 5 % en 2009 et de l'ordre de 1 % actuellement. Cela était suffisant pour détecter la présence d'une accélération récente de l'expansion du Cosmos observable, ceci impliquant la présence de la constante cosmologique d'Einstein. Mais, il est évidemment difficile dans ces conditions de mettre en évidence une éventuelle dérive faible de la valeur de la constante d'Einstein dans le passé de l'Univers, dérive qui aurait pu nous renseigner sur sa nature.

Le saviez-vous ?

Les équations de la relativité générale sont particulièrement difficiles à résoudre car elles sont non linéaires. L'une des caractéristiques qui font un bon physicien est la capacité de trouver des hypothèses permettant de simplifier les équations avec de judicieuses approximations qui permettent de les résoudre simplement tout en trouvant des solutions qui ne s'écartent pas trop des solutions exactes. On a donc fait l'hypothèse que si l'on considère l'Univers à suffisamment grande échelle, sa densité de matière est partout la même. On peut donc poser que le cosmos observable est une sorte de fluide de galaxies, tout comme l'eau nous apparaît un fluide à notre échelle et que nous ne notons pas le vide entre les molécules d'eau ni le fait qu'elles soient un peu plus nombreuses dans certaines régions.

Cette hypothèse semble particulièrement bien justifiée quand on observe l'Univers à une échelle de plusieurs centaines de millions d'années-lumière et surtout quand il était jeune, au moment où le rayonnement fossile a été émis. Cependant, presque 10 milliards d'années après le Big Bang, nous observons aussi que les galaxies ont fini par se rassembler pour former des filaments avec de grands vides à une échelle inférieure à plusieurs centaines de millions d'années-lumière.

Ne faudrait-il pas considérer des solutions aux équations d'Einstein dans lesquelles la répartition de la matière ne peut pas vraiment être considérée comme homogène bien qu'elle le soit un peu quand même ? La question se posait depuis un certain temps et de célèbres théoriciens, comme Robert Wald et Thomas Buchert, se sont affrontés sur l'importance ou non à donner en cosmologie relativiste les effets de la prise en compte d'un Univers finalement pas vraiment homogène. Le sujet est d'importance car, qui dit un Univers non homogène, dit un Univers dont la vitesse d'expansion, à un même moment global de son histoire, ne serait pas la même de façon non négligeable selon les densités, et donc les lieux, dans cet Univers.

Or, magiquement, quand on fait des moyennes avec ces densités variables dans les équations d'Einstein sans constante cosmologique au départ, on aboutit finalement à l'apparition de cette constante qui ne serait donc qu'un effet d'une physique très ordinaire et bien connue.

Toutefois, il faut bien dire qu'actuellement un très large consensus règne sur le fait que l'on ne peut vraiment PAS rendre compte de l'accélération observée en considérant un Univers inhomogène. Les effets possibles seraient négligeables, comme l'a expliqué Françoise Combes à Futura.

Parler d'une découverte d'une accélération et non pas de l'existence de l'énergie noire est d'importance, car on peut avoir la première sans la seconde comme on l'a dit au début de cet article et comme le bloc ci-dessus le précise. Admettons tout de même que l'énergie noire se cache bel et bien derrière la fameuse constante cosmologique d'Einstein que l'on a donc réintroduite dans les équations de la cosmologie relativiste. Plusieurs questions se posent alors.

Quelle est bien sûr la nature de cette énergie ? Est-elle vraiment constante dans le temps ou peut-elle varier ?

Découvrir que la constante cosmologique n'est en fait pas constante serait d'une importance cruciale car il existe des dizaines de propositions théoriques basées, par exemple, sur des théories de supergravité ou de supercordes, qui expliquent la nature de l'énergie noire et impliquent qu'elle varie dans le temps.

Pour tenter de répondre à ces questions, qui peuvent également nous aider à prédire quel sera le futur de l'Univers, Adam Riess et ses collègues ont donc entrepris de lancer il y a quelques années le projet Shoes (Supernova H0 for the Equation of State) afin de mesurer plus précisément les caractéristiques des nombreuses Céphéides pour augmenter la précision des mesures en cosmologie. Il y a quelques années, ils ont observé avec ce projet environ 70 céphéides regroupées dans des amas stellaires à l'intérieur du Grand Nuage de Magellan. Ces observations ont été combinées avec celles des membres du projet Araucaria, une équipe internationale d'astronomes qui s'est donné comme but de déterminer plus précisément la distance du Grand Nuage de Magellan.

Le résultat final fut double. Tout d'abord on connaît maintenant la valeur de la constante de Hubble avec une précision de l'ordre de 1 % et surtout, la probabilité que la valeur obtenue soit un effet des fluctuations statistiques (inévitables dans tout échantillonnageéchantillonnage d'une population) est passée de 1/3.000 à 1/100.000, un résultat beaucoup plus robuste.

La valeur trouvée avec l'aide du télescopetélescope Hubble était alors d'environ 74 km/s/Mpc, or celle déterminée avec le satellite Plancksatellite Planck est d'environ 67 km/s/Mpc. Le conflit semble donc certain puisque les membres de la collaboration Planck ont effectué un travail de détermination tout aussi solidesolide et ont longuement pensé à tous les biais d'observations possibles et aux moyens de s'en affranchir, comme l'avait expliqué à Futura la cosmologiste Laurence Perotto.

Des quasars comme sonde cosmologique

Venons-en maintenant à une autre méthode de détermination de la valeur actuelle de la constante de Hubble-Lemaître qui alimente également depuis quelque temps le débat sur l'existence ou non d'une révolution imminente en cosmologie et en physique.

Certainement pas au point de changer les grandes lignes de la théorie du Big Bang cependant.

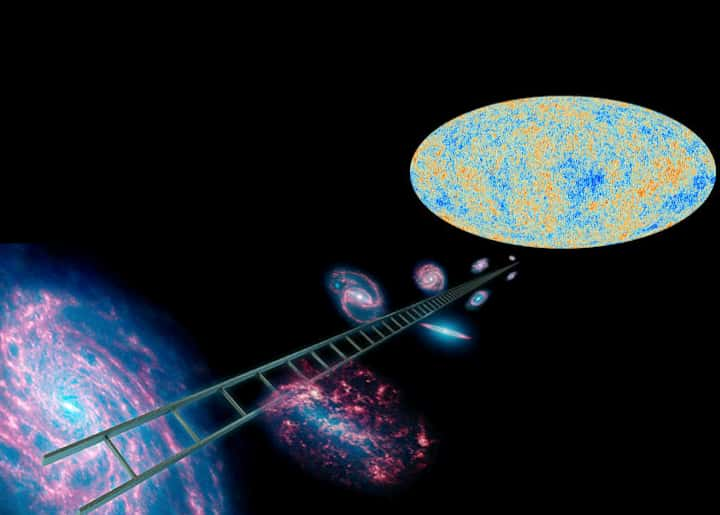

Elle a été mise en pratique par les membres de la collaboration HOLiCOW, un projet international en cosmologie mené par l'École polytechnique fédérale de Lausanne (EPFL) et le Max PlanckMax Planck Institute. Ils ont utilisé en premier lieu l'effet de lentille gravitationnellelentille gravitationnelle forte des galaxies sur plusieurs quasars et plus généralement sur l'impact de la dynamique de l'espace-tempsespace-temps dans un modèle cosmologique donné sur la propagation des rayons lumineux. La nouvelle méthode a conduit à nouveau à un conflit avec la mesure de la constante de Hubble-Lemaître fournie par Planck. Mieux, les membres de HOLiCOW ont retrouvé par cette méthode indépendante une valeur proche de celle déduite de l'étude des Céphéides.

Une vidéo expliquant le principe de la démultiplication des images d’un quasar par le champ de gravitation d’une galaxie déviant les rayons lumineux. © Royal Astronomical Society, ESA, Nasa

Pour aboutir à ce résultat, les astrophysiciensastrophysiciens ont travaillé dans le cadre du programme COSmological MOnitoring of GRAvItational Lenses (COSMOGRAIL) qui utilise principalement le télescope suisse de 1,2 mètre situé dans les Andes chiliennes, à proximité des observatoires de l'ESOESO. L'idée de base a consisté à mesurer des décalages de fluctuation de luminosité dans les multiples images de cinq quasars ayant subi un effet de lentille gravitationnelle. La méthode est plus directe que celles utilisées pour déduire du rayonnement fossile la valeur de la constante de Hubble. Elle repose sur moins d'hypothèses et donc de sources d'erreurs possibles à prendre en compte. Elle est donc plus robuste.

Une vidéo illustrant les décalages dans les fluctuations de luminosité des images d’un quasar avec un fort effet de lentille gravitationnelle. © Royal Astronomical Society, ESA, Nasa

Il y a de bonnes raisons de penser que les quasars sont en réalité des trous noirs supermassifstrous noirs supermassifs rendus très lumineux par l'accrétionaccrétion d'importantes quantités de matière. Leur luminosité fluctue en raison même de la physique des processus liés à l'accrétion et à la génération de rayonnements. Une galaxie massive qui s'interpose entre ce rayonnement et nous va dévier, en raison de son champ de gravitation, les rayons lumineux de sorte qu'ils ne suivront pas les mêmes chemins et ne parcourront pas les mêmes distances. Qualitativement et quantitativement, les temps de parcours sont affectés par l'expansion de l'univers observable et, au final, l'effet de lentille gravitationnelle va se manifester par des images d'un même quasar qui vont varier en luminosité avec des décalages dans le temps. Il est donc possible de déduire de ces décalages, une vitesse d'expansion et donc, la constante de Hubble-Lemaître.

Au final, on trouve une valeur d'environ 73 km par seconde par mégaparsec (un mégaparsec représente environ 3,3 millions d'années-lumièreannées-lumière). Le conflit avec les analyses des mesures du rayonnement fossile est désormais plus aigu car avec les Céphéides, il y a deux méthodes de mesure différentes, donc ne partageant pas les mêmes biais expérimentaux possibles, qui aboutissent à un résultat comparable.

En fait, se sont ajoutées tout récemment encore d'autres méthodes dont parlaient déjà les intervenants du colloque de 2019.

On a par exemple utilisé ce que l'on appelle en astrophysique le sommet de la branche des géantes rougesgéantes rouges (Tip of the Red Giant Branch en abrégé TRGB, en anglais), inspiré par le fameux diagramme de Hertzsprung-Russelldiagramme de Hertzsprung-Russell, représentant la luminosité des étoiles en fonction de leur indice de couleurcouleur, c'est-à-dire de leur température de surface. Il se trouve que dans le domaine de l'infrarougeinfrarouge, lorsque des étoiles sont sorties de la séquence principaleséquence principale en direction du bord supérieur droit du diagramme en devenant des géantes rouges, leur luminosité dans ce domaine devient relativement indépendante de leur massemasse et de leur composition. On peut donc les utiliser pratiquement comme chandelles standard, connaissant leur luminosité intrinsèque, et déterminer des distances comme avec les Céphéides et les SN Ia.

La méthode des TRGB a livré en 2019 une valeur pour H0 d'environ 70 km/s/Mpc, ce qui est à mi-chemin de la mesure avec Shoes (74 km/s/Mpc) utilisant les Céphéides et de H0LiCOW (73 km/s/Mpc) à partir de quasars, et de la prédiction de 67 km/s/Mpc de Planck.

Une constante cosmologique variable dans le temps ?

S'il n'y a pas d'erreurs dans les mesures de Planck, il est possible qu'il faille reconsidérer certaines des hypothèses admises concernant le modèle standard en cosmologie sur lequel sont basées certaines analyses et déductions des données de Planck mais aussi, et peut-être surtout, en physique des particules. La constante cosmologique n'est peut-être pas une vraie constante, ce qui a des implications sur la nature de l'énergie noire, ou peut-être existe-t-il une nouvelle famille de neutrinosneutrinos, des neutrinos dits stériles, une famille qui pourrait, cette fois, nous renseigner sur la nature de la matière noire.

En effet, comme Françoise CombesFrançoise Combes l'a expliqué à Futura :

« Il faut souligner que les valeurs de H0 sont obtenues avec des méthodes très différentes. Celle des Céphéides et chandelles standard est directe. Celle de Planck est tout à fait indirecte et dérive d'un modèle de concordance, avec des dizaines de paramètres. Donc il suffit d'en changer un, par exemple la masse des neutrinos, pour changer cette valeur de H0. »

Examinons rapidement pour terminer l'hypothèse d'une constante cosmologique variable dans le temps (en fait, et c'est peu connu Einstein et Schrödinger avaient envisagé dès le début cette hypothèse).

Pour commencer il faut savoir que la réintroduction d'une constante cosmologique dans les équations d'Einstein à la fin des années 1990 est venue à point pour résoudre deux problèmes. Déjà du temps d'Einstein (voir ce qu'il en dit dans l'appendice consacré à la cosmologie de son merveilleux ouvrage The meanging of relativity), les mesures de la vitesse d'expansion de l'Univers en rapport avec la valeur de la constante de Hubble-Lemaître conduisaient à attribuer une date de début d'expansion dans des modèles cosmologiques de type Big Bang considérés par Lemaître en contradiction avec les âges des plus vieilles étoiles connues dans les amas d'étoiles déterminés par la théorie de l'évolutionthéorie de l'évolution stellaire.

L'espace-temps semblait plus jeune que son contenu en étoiles.

La contradiction allait être questionnée avec les nouvelles déterminations par la suite de la constante de Hubble-Lemaître. Mais déjà, dès les années 1960, le célèbre astronome Alan Sandage avait compris que l'on pouvait résoudre la contradiction si la valeur de Λ n'était pas zéro comme on avait fini par le croire dans les décennies précédentes. Au cours des années 1980 et 1990 le problème est réapparu et certains se demandaient si encore une fois il ne fallait pas introduire une valeur pour Λ non nulle.

Surtout, la prise au sérieux de plus en plus grandissante de la théorie de l’inflation au cours des années 1980 et 1990, basée sur l'existence d'une phase très courte mais très violente d'accélération de la vitesse d'expansion du cosmos dans l'Univers primordial (en raison de l'existence d'un champ scalaire cousin de celui du fameux boson de Brout-Englert-Higgs entraînant l'existence d'une énergie du vide variable), impliquait un cosmos observable possédant une densité de masse que même avec la matière noire on n'arrivait pas à atteindre. Techniquement, il fallait avoir ce que l'on appelle la densité critiquedensité critique et une constante cosmologique pouvait fournir la composante de masse manquante, ce qu'a précisément permis de faire la découverte de l'accélération de l'expansion.

Il semble aujourd'hui que l'on peut résoudre la contradiction entre les données de Planck et les autres déterminations de la valeur de la constante de Hubble-Lemaître en supposant, peu de temps avant l'époque de la recombinaisonrecombinaison qui a marqué la naissance du rayonnement fossile, une composante d'énergie noire transitoire et variable. Elle serait probablement du type de celle déjà proposée là aussi avec un champ scalaire et que l'on appelle un modèle de quintessence. Après la recombinaison, cette énergie du vide serait bien celle à l'origine de la constante cosmologique mais elle serait bien constante dans le temps justement. De nombreuses théories au-delà du modèle standard prédisent l'existence de champs scalaires ayant reçu de nombreux noms, k-essence, caméléons, etc.

Pour finir - et parce qu'Auguste Comte disait que l'on ne sait pas une théorie, une science, tant que l'on en connaît pas l'histoire -, il existe une excellente référence à ce sujet pour la constante cosmologique. On la doit au prix Nobel de Physique James Peebles, l'un des architectesarchitectes du modèle ΛCDM.

Futura a 20 ans

BONNE NOUVELLE : PROLONGATIONS ! #LeMagFutura

Grâce au succès incroyable de la collecte, la campagne du Mag Futura a obtenu le droit de jouer les prolongations ! Le Mag Futura sera donc encore disponible en pré-commandes jusqu’au 5 janvier. Alors, hâtez vous de le dire à la Terre entière !

Je précommande le Mag Futura maintenant !

Le Mag Futura, c'est quoi ? Une revue de plus de 200 pages, 4 dossiers sur la Science qui marquera 2022, zéro fake news, juste de la Science !

Le Mag Futura : les derniers exemplaires !

Le Mag Futura : les derniers exemplaires !