au sommaire

En robotiquerobotique, les capteurscapteurs et les actionneurs ne sont opérants que parce qu'ils sont reliés à un dispositif de contrôle, autrement dit, à une sorte de système nerveux. Alors, les robotsrobots ont-ils un cerveaucerveau ?

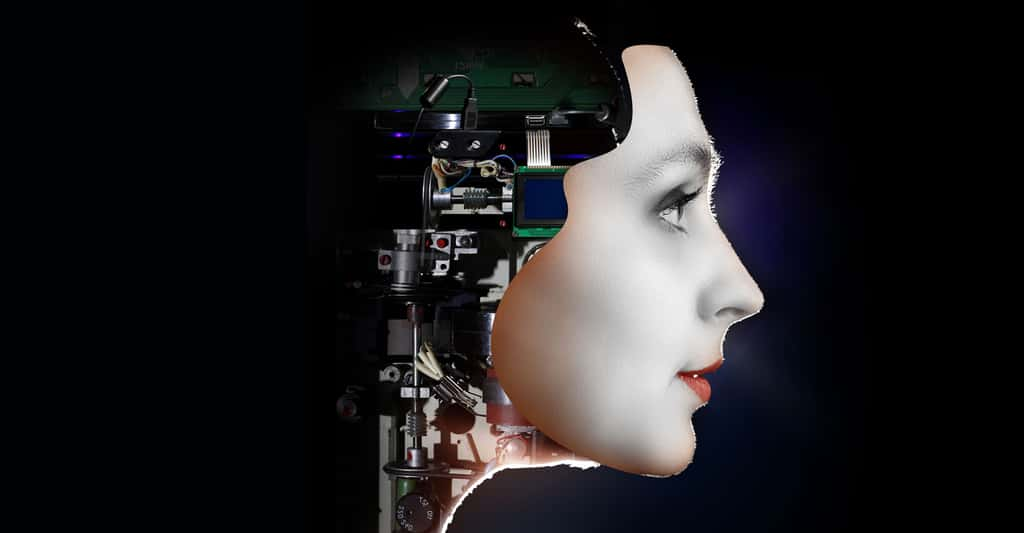

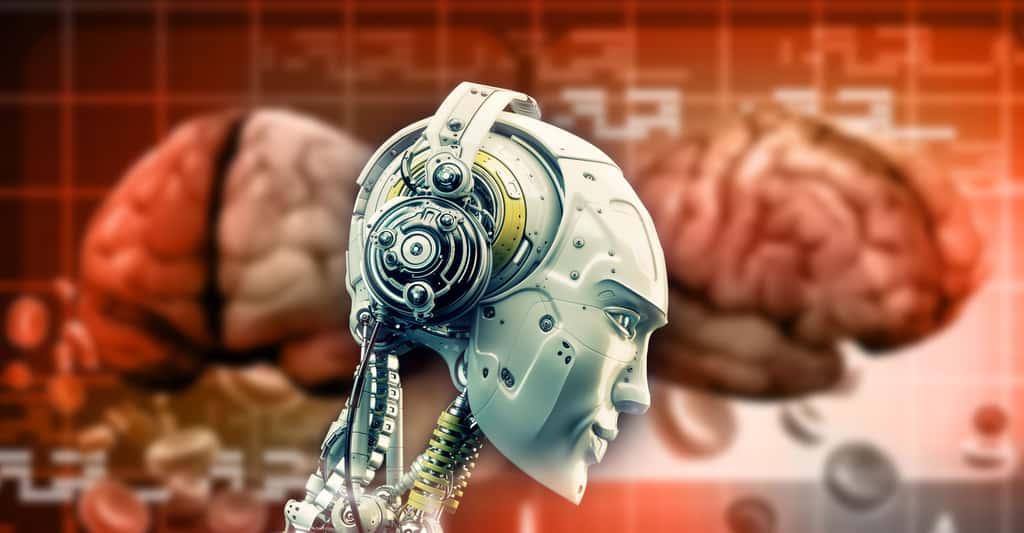

Le cerveau des robots. © Ociacia, Shutterstock

Les réseaux neuronaux artificiels

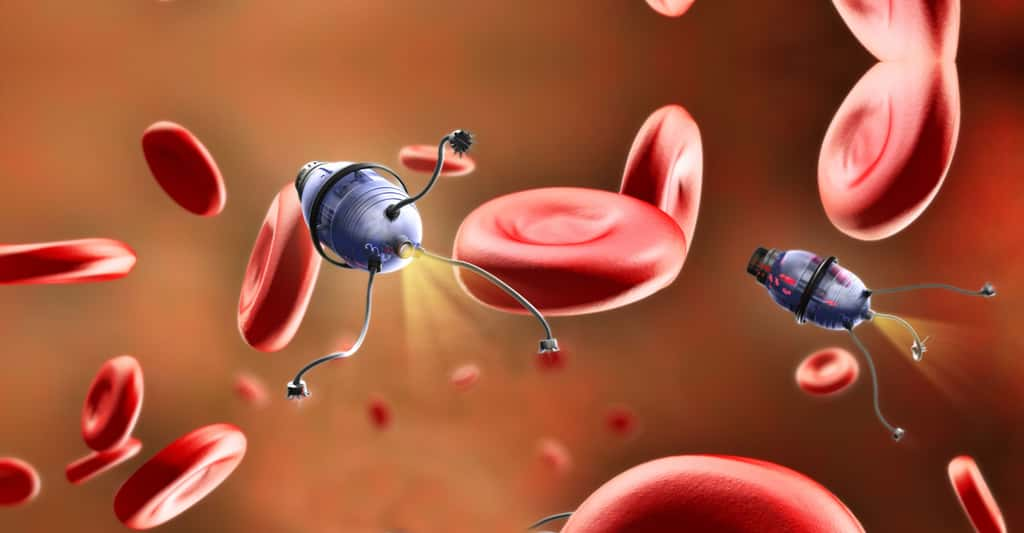

Rétrospectivement, on observe une ligne directrice, paradoxale, qui a guidé les travaux dans ce domaine (et ce jusqu'aux plus récents) : l'être humain s'est peu à peu retiré de la conception des architectures de contrôle. Ces développements sont allés de pair avec les progrès de l'informatique, notamment en matière de puissance de calculs, mais aussi avec l'amélioration des réseaux de neurones artificiels. Ceux-ci sont représentés par des programmes informatiques qui reçoivent des valeurs d'entrée et délivrent des valeurs de sortie. Reliés aux capteurs, aux actionneurs ou à d'autres neuronesneurones, ils tissent un réseau qui constitue le « système nerveux » du robot.

Dans les premiers dispositifs, tous les paramètres de ce réseau étaient fixés et dérivaient -- le plus souvent -- des connaissances acquises en biologie. Dans un second temps, ont été élaborés des animatsanimats qui modifiaient eux-mêmes leur système nerveux par des étapes d'apprentissage, où des succès et des échecs précèdent des réajustements dans les connexions entre les neurones. Ici, l'architecture est figée et imposée par le concepteur ; en revanche, les forces excitatrices ou inhibitrices des connexions varient. Enfin, cette émancipation a atteint son apogée dans l'application, dès les années 1990, des algorithmes génétiquesgénétiques et autres méthodes évolutionnistes qui dérivent de l'évolution darwinienne.

Les robots ont-ils un cerveau ? © DR

Darwin chez les robots ?

On teste alors l'efficacité d'une population d'une centaine de systèmes nerveux, élaborés au hasard, dans la tâche qu'un robot doit accomplir. Les meilleurs ainsi qu'une poignée de moins performants « engendrent » une deuxième génération qui résulte de croisements et de modifications aléatoires des systèmes retenus.

Cette deuxième génération est à son tour testée dans les mêmes conditions que la précédente et le même processus de sélection-reproduction est répété. Après quelques milliers de générations, les systèmes nerveux élaborés confèrent à l'animat un comportement efficace. Les architectures de contrôle des robots canins et androïdesandroïdes mis au point par la société Sony, à Tokyo, relèvent notamment de cette robotique évolutionniste.

L'androïde SDR-4X (à gauche) et le chien Aibo (à droite). © Sony

Vers l'apprentissage autonome pour les robots

L'émancipation se poursuit et l'on tente de minimiser encore le rôle du concepteur humain dans la structure même des systèmes de contrôle. Ainsi, des cellules nerveuses artificielles apparaissent, disparaissent et se relient jusqu'à l'élaboration d'un système adapté.

Peu à peu, grâce à ces procédures inspirées de la biologie, le roboticien pourrait progressivement être libéré de toutes les idées préconçues qui risquaient de biaiser la conception de ses systèmes. Par exemple, il ne choisira bientôt plus la nature, le nombre et la position des capteurs visuels d'un robot ; ceux-ci seront plus efficacement déterminés sous la contrainte d'une sélection artificiellesélection artificielle. Le roboticien est en passe de reproduire, en accéléré, plusieurs milliards d'années d'évolution... Cependant ces méthodes évolutionnistes ont connu récemment leur limitation, car elles ne se sont révélées efficaces que lorsque la conception de l'animat n'est pas trop complexe.

Hexapod (AnimatLab, à gauche) a fait évoluer un « cerveau » pour pouvoir marcher et Golem (Brandeis University, à droite) a conçu par évolution à la fois une morphologie et son « cerveau » qui lui permettent de ramper. © DR

Depuis 2010, un autre système d'apprentissage a le ventvent en poupe, l'apprentissage profondapprentissage profond (deep learning). Inspiré de l'activité de différentes couches neuronales du cortexcortex humain, il multiplie les apprentissages en donnant au calcul d'une couche de neurones artificiels les sorties de la couche précédente, et cela pour une dizaine ou une vingtaine de couches. Le système peut ainsi se « représenter le monde » d'une manière beaucoup plus signifiante qu'un apprentissage classique, comme la reconnaissance d'objets déformés ou des émotions sur un visage. C'est aussi par cette méthode qu'en 2016 le logiciel AlphaGo a réussi à battre le champion du monde de jeu de go.