au sommaire

- À lire aussi

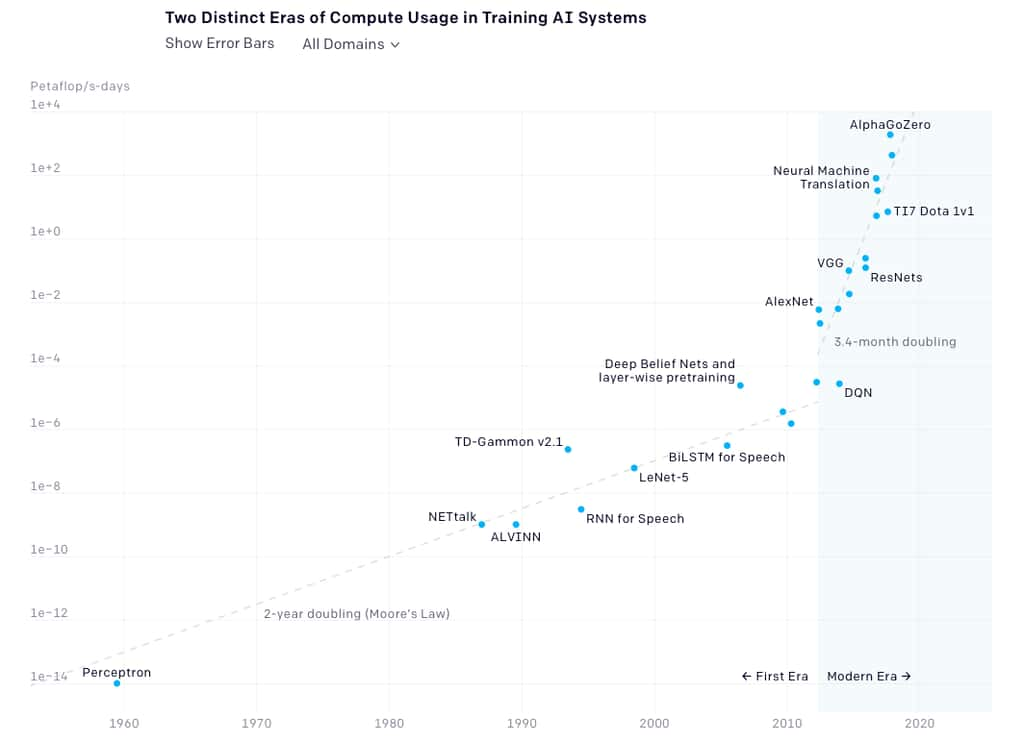

La puissance de calcul nécessaire pour les algorithmes d'intelligence artificielleintelligence artificielle double tous les 3,4 mois, selon une analyse de l’entreprise OpenAI, qui vise à développer une IA « responsable ». Entre 1959 et 2012, cette progression suivait la loi de Mooreloi de Moore, la puissance doublant tous les deux ans. Mais depuis l'émergenceémergence des réseaux neuronaux modernes en 2012, la puissance de calcul a été multipliée par 300.000, soit un taux de progression sept fois plus rapide. Le programme AlphagoAlphago Zero nécessite ainsi 1.860 petaflops par seconde et par jour alors qu'Alexnet, le réseau neuronal conçu par Alex Krizhevsky et sorti en 2012, ne tournait « que » avec 0,0054 petaflop par seconde et par jour.

« Cette tendance est due notamment à la baisse des coûts du calcul (nombre d'opérations par wattwatt), mais aussi par de nouvelles configurations des réseaux qui utilisent toujours plus de puces en parallèle », rapportent les ingénieurs d'OpenAI. Et cette course au petaflops n'est pas prête de s'arrêter : « le budget informatique mondial est de 1.000 milliards de dollars par an et les limites de ce budget semblent lointaines », euphémise OpenAI. Autrement dit, la recherche en IA bénéfice pratiquement d'un « open barbar » pour acquérir toujours plus de puissance informatique. Le problème, c'est que ces énormes serveursserveurs génèrent aussi une énorme pollution : une étude de l’université du Massachusetts sortie en juin 2019 avait calculé que l'entraînement d'un programme d'apprentissage de langage naturel tel que Transformer générait jusqu'à 300 tonnes de CO2, l'équivalent de 60 années d'émissionsémissions pour un humain.