Au commencement de l'informatique domestique il y eut le CPU (Central processing unit, par exemple l'IntelIntel Pentium I). Le traitement des données dépendait de cette galette de siliciumsilicium, chef d'orchestre du matériel. La génération d'interfaces graphiques s'effectuait grâce à ce processeur assorti d'un adaptateur 2D. Ainsi, du bureau en deux dimensions aux affichages primaires en trois dimensions, toutes les tâches reposaient sur cette combinaison, le CPU restant le facteur clé du duo. Un temps réservé à des tâches intellectuelles et créatives le PC fut bientôt utilisé à des fins récréatives. De la platitude de l'indémodable démineur aux premiers jeux en volumevolume, les besoins en capacité de calcul changèrent drastiquement.

La folle course des cartes graphiques

A l'inverse d'une image de synthèse générée par un algorithme sur un temps donné, il s'agissait de générer des dizaines d'images par seconde interactives, ce avec de plus en plus de réalismeréalisme. Aussi, l'avènement du marché des cartes graphiques 2D-3D découle-t-il de ce besoin rapide de capacité de traitement. Complément de la carte-mère, l'architecture de ce périphérique interne s'articule autour d'un processeur appelé GPU (Graphical Processing UnitGraphical Processing Unit) et dispose par exemple de sa propre mémoire vivemémoire vive. Partant de feufeu le port ISA (Industry Standard Architecture), elle passa au port PCI, à l'AGP, puis à l'actuel PCI ExpressPCI Express. La carte graphique a gravi les échelons pour devenir un élément à peu près indispensable dans le domaine d'applicationsapplications d'affichages poussés. Longtemps considérée comme réservée aux jeux, elle s'est vu récemment adoubée par les interfaces de système d'exploitationsystème d'exploitation, mais aussi, par le calcul pur.

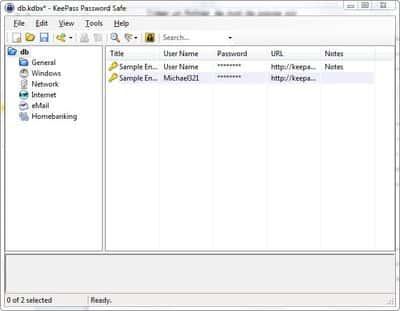

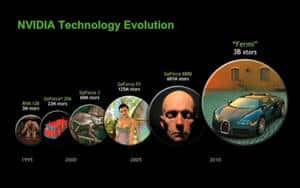

Cliquer pour agrandir - L'évolution de la 3D temps-réel de ces 15 dernières années, selon NVidia. © NVidia

Avec l'augmentation gigantesque de leurs performances, les GPU peuvent maintenant effectuer des calculs parallèles dantesques. D'abord utilisé à des fins de décryptage, l'ancien compagnon du CPU est entré en concurrence directe avec son comparse. C'est la firme ATI qui donna la première le véritable coup d'envoi, en transformant le périphérique de jeux en supercalculateursupercalculateur nommé Firestream. La firme concurrente, NVidia, s'est empressée de lui emboîter le pas avec son CUDA optimisé pour une architecture de calculs parallèles. A titre d'exemple, une carte NVidia Geforce 8800 comporte 128 cœurs (stream processors), à comparer aux 8 cœurs du Cell d'IBMIBM, même si les architectures ne sont pas directement comparables. Des cartes de gamme grand-public permettent désormais l'émergenceémergence de super-ordinateursordinateurs abordables et des perspectives nouvelles s'annoncent pour l'industrie des cartes 3D. Le bonheur des joueurs fait ainsi celui des chercheurs qui peuvent s'appuyer sur ce genre de circuit pour réaliser des modélisationsmodélisations en astrophysiqueastrophysique ou dans le domaine climatique. L'annonce du projet Fermi par NVidia, avec son GPU doté de 512 coeurs, conforte le phénomène.

Rendre à la 3D ce qui est à la 3D

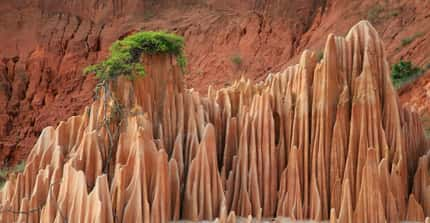

Paradoxalement c'est le rendu tridimensionnel qui tire le plus de profit de cette course au calcul parallèle. En effet il existe différents types de rendu 3D parmi lesquels deux principaux, à savoir l'image de synthèse générée par des algorithmes et le rendu en temps réel s'appuyant sur des bibliothèques logicielles (majoritairement DirectX et OpenGL). Ce n'est un secret pour personne, l'image de synthèse a fait d'énormes progrès en deux décennies. Alors que le rendu d'un dinosauredinosaure de Jurassic Park demandait de deux à six heures par image suivant les conditions (pluie, éclairages...), le rendu d'une scène complète de la version de 2005 de King Kong ne prenait qu'une nuit. A l'inverse de la 3D temps réel actuelle qui se base sur des effets prédéfinis, une image de synthèse demande des calculs pointus. La méthode la plus utilisée est le ray tracingray tracing (lancer de rayon) qui consiste à calculer l'interaction des objets, de la matièrematière et de la lumièrelumière par un procédé vectoriel. Les algorithme basés sur le ray tracing demandent des capacités de calcul importantes, capacités que les constructeurs ATI/AMD et NVidia peuvent maintenant fournir pour un rendu photo-réaliste en temps réel.

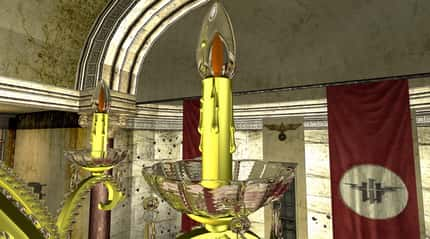

Personnage généré en temps réel grâce au procédé Cinema 2.0 (anglais). © Image Metrics, ATI/AMD

Sous le nom d'iRay que Nvidia a dévoilé son moteur de rendumoteur de rendu réaliste, qui exploite les capacités des GPU Fermi embarqués dans une infrastructure de serveursserveurs nommée TeslaTesla. C'est en septembre dernier que le fondeur américain a dévoilé sa création. Force est de constater que depuis les 3 heures par image requises pour Jurassic Park, un pas énorme a été franchi. C'est en temps réel que le démonstrateurdémonstrateur se promène dans une pièce, change les éclairages et ajoute des éléments. Les capacités de traitement parallèles du Fermi associées au ray tracing font des miracles.

Démonstration du moteur 3D iRay mis au point par NVidia. © Luminova

Ce type de démonstration resterait anecdotique si elle n'aboutissait pas à un résultat concret pour l'utilisateur lambda. Dans ce domaine NVidia frappe fort avec l'annonce de la fusionfusion de son moteur iRay avec le principe, en pleine expansion, du cloud computingcloud computing (capacités de calcul et de stockage centralisées dans le cadre d'un réseau, par exemple le service bureautiquebureautique de GoogleGoogle est du cloud computing). Le but est de proposer une solution de rendu 3D photo-réaliste contrôlable en temps réel, qui ne fasse pas appel aux ressources de la machine de l'utilisateur. Ce sont les fameux serveurs Tesla qui se chargent du calcul des données graphiques, dans la limitation des capacités du réseau en terme de débitdébit. A terme il sera donc possible de visualiser une voiturevoiture sous toutes ses coutures « comme si vous y êtiez », ce dans un navigateurnavigateur InternetInternet. L'infrastructure se nomme RealityServer et est définie par NVidia comme « le futur des applications 3D sur internet ».

Il faudra cependant s'armer de patience pour espérer pousser l'expérience jusqu'à la visite d'un monde virtuel photo-réaliste via le cloud computing. En effet, le débit actuel des connexions Internet est un frein pour ce type d'usage. Cependant il y a fort à parier que les sites marchands sauront saisir l'occasion...