Aux États-Unis, des chercheurs ont trouvé une nouvelle approche pour rendre les réseaux neuronaux utilisés par les intelligences artificielles plus efficaces. En intégrant une mémoire de travail à travers le réseau, les synapses peuvent se mettre à jour en temps réel, limitant considérablement le nombre d’opérations de traitement des données.

au sommaire

L'intelligence artificielle (IA) est très gourmande en énergie et notamment pendant sa phase d'entraînement. C'est un problème d'une telle ampleur qu'Elon MuskElon Musk a prédit que le monde manquerait d’électricité pour les IA d'ici à un an. Mais des chercheurs du Cold Spring Harbor Laboratory aux États-Unis ont peut-être trouvé la parade, en s'inspirant du cerveaucerveau humain.

« Aussi impressionnants que soient ChatGPTChatGPT et toutes ces technologies d’IA actuelles, en termes d'interaction avec le monde physiquephysique, elles sont encore très limitées. Même dans des domaines comme résoudre des problèmes de mathématiques et rédiger des dissertations, il leur faut s'entraîner sur des milliards et des milliards d'exemples avant de pouvoir les faire correctement », a expliqué Kyle Daruwalla, l'auteur principal de l'article publié dans la revue Frontiers in Computational Neuroscience.

Une mémoire de travail pour permettre la mise à jour des synapses

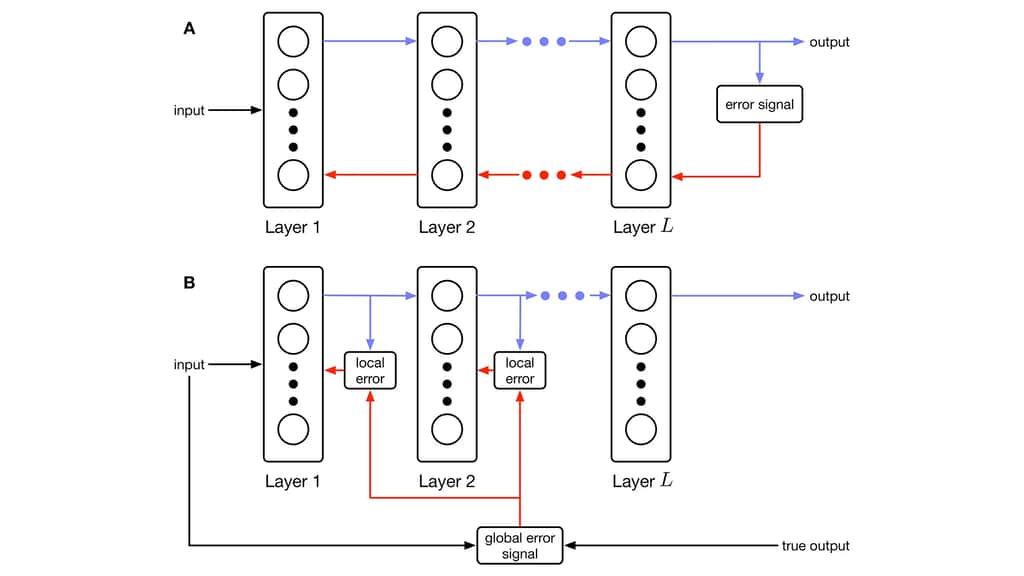

Pour lui, le problème se situe au niveau du déplacement des données. Les réseaux neuronaux artificiels sont composés de milliards de connexions, et les données doivent traverser des circuits complets avant que le modèle ne se mette à jour. Avec cette nouvelle approche, chaque neurone artificiel reçoit un retour grâce à un réseau de mémoire auxiliaire et peut être modifié en temps réel.

Cela crée une connexion directe entre la mémoire de travailmémoire de travail et les mises à jour synaptiques, apportant un nouvel élément de preuve à une théorie non prouvée en neurosciences qui lie la mémoire du travail à l'apprentissage et la performance académique. Cette nouvelle approche pourrait donc réduire considérablement la puissance de calcul et par conséquent l'énergieénergie nécessaire pour le fonctionnement des intelligences artificielles.