Chaque année, la revue Technology Review offre son palmarès des technologies qui, selon elle, marqueront l’année qui vient. Pour 2008, on remarquera qu’ont été sélectionnées un certain nombre de technos qui touchent à l’incertitude, à la complexité et aux rapports sociaux. Il semble bien que les chercheurs s’aventurent aujourd’hui dans des domaines dangereux où les certitudes bâties par Newton et Descartes s’effondrent.

au sommaire

- À lire aussi

Technologies émergentes : les surprises de 2008

On ne peut être qu'étonné par ce projet d'un nouveau modèle de processeur probabiliste, capable de se tromper légèrement dans ses calculs. Quel intérêt ? Consommer moins... En effet, les processeurs dépensent beaucoup d'énergieénergie pour éviter toute erreur. Lorsque les premiers ordinateurs ont été créés, ils devaient essentiellement gérer des tâches pour lesquelles l'exactitude était une exigence fondamentale, que ce soit le lancement de fuséesfusées ou les bilans comptablescomptables. Mais aujourd'hui, on manipule des informations beaucoup plus floues, comme le son ou la musique. Quelle importance si le processeur se trompe un peu sur la couleurcouleur d'un pixel, sur la tessiture d'un instrument de musique ou la hauteur d'une note ? Après tout, la compression avec perte (comme dans le cas du MP3) nous a habitués à ces petites infidélités qui se trouvent au-dessous du seuil de perception. En utilisant un tel système probabiliste, on peut largement faire baisser la tension électrique nécessaire aux processeurs et allonger la duréedurée de vie des batteries des ordinateurs portables ou des mobilesmobiles. Mais dans un avenir plus lointain, le système permettrait de poursuivre l'amélioration constante des processeurs décrite par la fameuse loi de Moore. La miniaturisation approche en effet un stade, celui de la physique quantiquephysique quantique, où l'exactitude devient impossible et où la probabilité devient la règle. Or ce nouveau type de processeur intègre justement une logique probabiliste qui peut gérer ce genre d'incertitudes.

Le comportement humain sous l'œilœil des modélisateurs

Encore de l'inconnu et de l'imprévu : comment modéliser la surprise ? L'expression même peut sembler contradictoire, car la surprise, c'est par définition ce qu'on n'arrive pas à prévoir. Pourtant, ce n'est pas la première fois que des chercheurs essaient de décrire l'inattendu : les multiples théories du chaos, de la complexité ou les systèmes multi-agents en témoignent. Mais ces recherches restent pour la plupart théoriques. Eric Horvitz, qui dirige le groupe Systèmes adaptatifs et interaction au sein de MicrosoftMicrosoft research, a essayé de développer une applicationapplication pratique. Il a donc créé Smartphlow, qui observe le trafic de la ville de Seattle et envoie des alertes aux conducteurs uniquement lorsqu'il se passe un évènement inattendu : par exemple un bouchon dans une rue généralement fluide. Horvitz espère par la suite appliquer ses techniques à d'autres domaines, par exemple la prédiction de conflits armés.

Le comportement humain, voilà encore un phénomène bien difficile à modéliser. Au MIT, Sandy Pentland utilise les téléphones cellulaires pour repérer un certain nombre de constantes dans les actions des différents utilisateurs. Il aimerait que les téléphones portables se montrent encore plus capables de capter des informations sur leur utilisateur, comme leur activité physique. Une telle indiscrétion permettrait, selon lui, d'examiner et d'améliorer les conditions de travail, le bien-être des communautés, et même de prédire les épidémiesépidémies ou l'état de santé d'un utilisateur.

Les neurosciences à l'honneur

Encore de la complexité avec la "connectonomie", l'une des deux technologies touchant aux neurosciences dans ce Top dix 2008. Le travail de Jeff Lichtman, à Harvard, consiste à cartographier les interactions entre neuronesneurones au sein du cerveaucerveau des mammifèresmammifères. Jusqu'ici, les scientifiques ne disposaient pas de diagrammes leur permettant de saisir d'un coup d'œil l'ensemble d'une configuration de plusieurs centaines de neurones.

Peut-être un jour Lichtman utilisera-t-il pour ses travaux des "magnétomètres atomiques", la seconde des technologies sélectionnées cette année ayant un rapport avec les neurosciences. Les capteurscapteurs de champs magnétiqueschamps magnétiques sont en effet utilisés pour obtenir des images précises du cerveau grâce à la technique de l'IRMIRM (imagerie à résonancerésonance magnétique), mais ils ont bien d'autres usages, notamment en chimiechimie. Problème : pour obtenir des données assez précises, il faut un capteur énorme. Le physicienphysicien John Kitching a mis au point des capteurs très précis d'une taille analogue à celle d'un grain de riz. Si sa technologie se généralise, on pourrait donc par exemple concevoir des appareils à IRM beaucoup plus petits, voire portables.

L'essor des nanotechnologies

Dans la série small is beautiful, Technology Review a également placé dans sa sélection des nanoradio", basées sur un unique nanotube. Ces radios sont si petites qu'il pourrait un jour devenir possible de les implanterimplanter directement dans le corps : elles seraient alors en mesure d'envoyer des informations sur la santé de leur porteur à un détecteur situé à l'extérieur.

On a vu que le processeur probabiliste était un moyen de contourner la loi de Moore. Une autre possibilité serait de remplacer le siliciumsilicium par le graphène, un cristal de carbonecarbone des plus communs, puisqu'à l'origine du graphitegraphite de nos crayons noirs (mais également des nanotubesnanotubes et des fullerènesfullerènes). Selon Walter de Heer, du Georgia Institute of Technology, ce nouveau matériaumatériau pourrait multiplier la vitessevitesse des ordinateurs de demain : « Il existe une limite physique à la vitesse obtenue avec le silicium, un point au-delà duquel vous ne pouvez plus accélérer ses performances. Nous sommes actuellement bloqués au niveau du gigahertz. Mais avec le graphènegraphène, je crois qu'on pourrait monter jusqu'au térahertz - mille fois un gigahertz... » Futura-Sciences a publié plusieurs articles sur le graphène et ses applications.

L'énergie

Deux autres des technologies mentionnées par Technology Review concernent l'énergie. La première est la généralisation de l’électricité sans fil. Aujourd'hui, transmettre de l'énergie sans fil est compliqué. Par les ondes radio, la déperdition est trop importante. Quant au laserlaser dans un réseau point à point reliant les appareils, la technique est trop contraignante. D'où l'idée de Marin Soljacic, professeur de physique au MIT, d'explorer une autre piste : celle de la résonance, qui repose sur le fait que deux objets émettant à une même fréquence échangent une grande quantité d'énergie. L'exemple classique est celui du verre qui explose quand un chanteur parvient à émettre un son à la même fréquence que le verre. Les premières expérimentations sont plutôt concluantes, même si elles portent sur de courtes distances (quelques mètres) et de faibles puissances (60 wattswatts), avec une déperdition plus faible que d'autres technologies (50 % de la puissance pour l'instant). Contrairement aux techniques de recharge par induction proposées par Powercast, Fulton Innovation ou WildCharge, la technologie de Soljacic permettra peut-être un jour de recharger automatiquement des batteries, sans avoir besoin de tablettes de chargement.

L'autre technologie énergétique émergente couronnée par Technology Review se base sur les travaux visant à améliorer la production de biocarburantsbiocarburants à partir de la dégradation de la cellulose, et utilisant des matériaux comme le boisbois, la paille ou les déchetsdéchets agricoles. Contrairement aux autres techniques de création de biocarburant, cette filière cellulosique n'utilise pas de ressources alimentaires comme le maïsmaïs ou la canne à sucresucre. Elle est aussi plus écologique : elle est capable de réduire les émissionsémissions de gaz à effet de serregaz à effet de serre de 87 % par rapport à l'utilisation des dérivés du pétrolepétrole. A titre de comparaison, un biocarburant comme l'éthanol produit à partir du maïs ne réduit ces émissions que de 18 à 28 %. Mais hélas, la production de biocarburant cellulosique à l'échelle industrielle est chère et non rentable. Frances Arnold, professeur d'ingénierie chimique et de biochimiebiochimie au Caltech, pense avoir trouvé la solution : les enzymes. En effet, une seule de ces protéinesprotéines suffit à transformer le maïs en sucre, lequel est une source d'énergie. Mais au contraire, il faut un ensemble d'enzymesenzymes pour dégrader la cellulosecellulose et produire de l'énergie. Frances Arnold cherche à créer des micro-organismesmicro-organismes capables d'effectuer ce travail de manière plus efficace. Pour cela, elle a utilisé une technique dite d'évolution dirigée pour créer une multitude de séquences ADNADN capables de coder de nouvelles protéines. Puis elle insère ces gènesgènes mutants dans des bactériesbactéries pour tester leur action. En effet, il ne s'agit pas seulement de trouver une bonne enzyme mais de constituer un groupe de travail de plusieurs d'entre elles, capables de collaborer efficacement.

Sur le Web

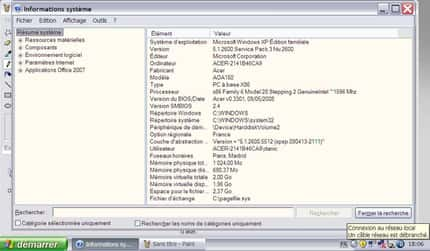

La seule technologie Web a avoir été distinguée est celle des applications Web offline, comme celle développée par Adobe avec AIRAIR (Adobe Integrated Runtime), permettant d'accéder à des applications en ligne et hors ligne (voir les applications déjà disponibles). Pour Kevin Lynch, architectearchitecte logiciellogiciel chez Adobe, ce type d'applications hybrideshybrides devrait permettre aux utilisateurs de tirer simultanément avantage d'InternetInternet comme des capacités de leurs propres machines. AIR est un environnement d'exécution, une couche logicielle qui permet à un même programme de fonctionner sur tout type de système d'exploitationsystème d'exploitation ou de matériel : un logiciel développé à partir d'AIR n'aura donc pas besoin d'être adapté pour fonctionner sur différents systèmes. Pour Lynch, AIR est la réponse à l'évolution du Web vers un média plus interactifinteractif. Alors que le navigateurnavigateur était créé pour les pages web, Lynch estime que nous avons désormais besoin d'interfaces plus appropriées pour le "Web logiciel" que nous utilisons aujourd'hui.