Comment « pense » une IA ? Alors que paradoxalement, les intelligences artificielles sont créées par les humains, leur fonctionnement nous échappe au fil de leurs progrès. Pour répondre à cette question, les chercheurs d’Anthropic ont disséqué le « cerveau » de l’IA Claude 3.

au sommaire

Inquiétantes, fascinantes, les intelligences artificielles (IA) font désormais partie de notre quotidien et alors que ce sont des créations humaines, elles développent leur part de mystère au fil de leurs progrès. Futura avait déjà évoqué les recherches qu'effectuent les scientifiques sur le fonctionnement des IA et leurs grandes difficultés à le cerner. Ils parlent même de « boîte noire », car ils ne savent pas vraiment comment l'IA avec les quantités astronomiques de données ingurgitées a construit sa propre compréhension du monde.

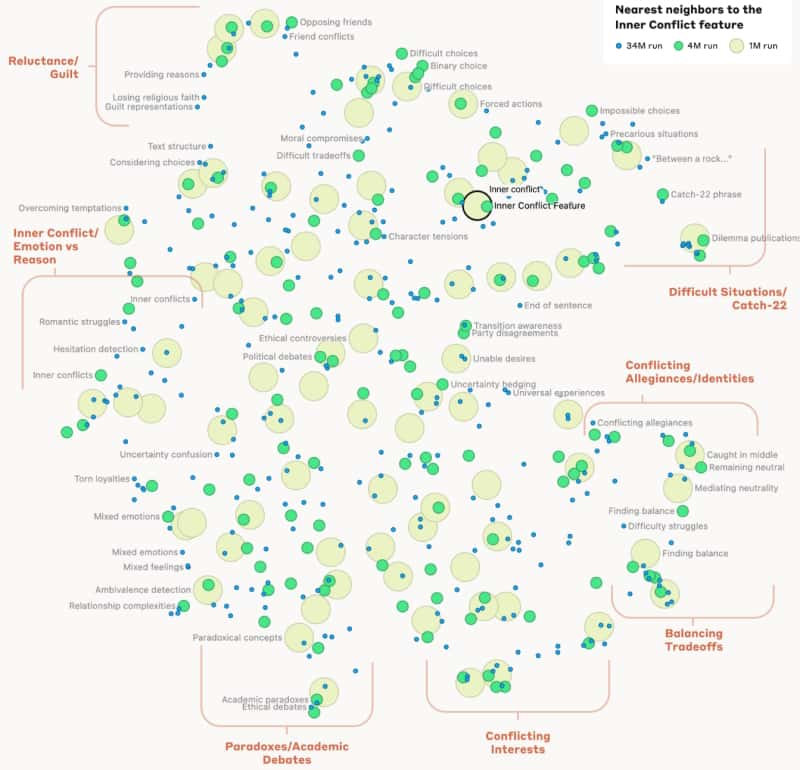

Aujourd'hui, des chercheurs issus d'Anthropic, la société qui développe le chatbot Claude, affirment qu'ils sont justement capables de pénétrer cette boîte noire et même de modifier le fonctionnement du cerveaucerveau des IA. Dans une publication, ils expliquent qu'ils ont pu cartographier les chemins de « pensée » de leur propre IA. En utilisant une technique appelée « apprentissage par dictionnaire », l'équipe d'Anthropic a pu faire correspondre les modèles d'« activation neuronale » de l'IA avec des idées et des concepts familiers aux humains. Ces expériences ont été menées sur des versions de modèles de langage très restreintes afin de découvrir les « schémas de pensée » qui s'activaient lorsque les modèles traitaient de certaines idées. Lors de ces tests, il est apparu que l'IA parvenait à trier les concepts parfois éloignés et à les lier entre eux d'elle-même, mais à sa façon. Certains concepts sont plus ou moins regroupés ou éloignés dans « l'esprit » de Claude.

Si l'expérience a bien fonctionné sur ce petit modèle, comment réaliser la même chose avec un modèle de langage alimenté par une base colossale de données ? Les chercheurs d'Anthropic ont pour cela construit un modèle d'apprentissage de taille moyenne à partir de Claude 3. Là encore, ils sont parvenus avec succès à extraire suffisamment de données pour créer une carte des concepts élaborée par l'IA lorsqu'elle est en train de « penser ». Ainsi, ils ont appris que l'IA stocke les concepts de manière indépendante du langage, ou même du type de données.

Retirer les mauvaises pensées des IA

Pour les idées les plus abstraites, le modèle est même capable de regrouper certains concepts pourtant parfois éloignés. C'est le cas des situations sans issue ou sans solution, par exemple. Le fonctionnement est alors assez similaire à celui du cerveau humain. Avec cette nouvelle connaissance du fonctionnement du cerveau de l'IA, les chercheurs ont pu manipuler certaines de ses caractéristiques en amplifiant des concepts ou en les supprimant pour vérifier comment les réponses de Claude pouvaient changer. Par exemple, en réduisant la portée de certains concepts issus de cette cartographie mentale, cela déclenchait un comportement totalement différent de l'IA.

Pour l'équipe, l'objectif de ces recherches était essentiellement de renforcer la sécurité. En sachant précisément où se trouvent les concepts issus de « mauvaises pensées » ou de « pensées nuisibles », et en vérifiant quand l'IA les exploite pour générer ses réponses, cela permet de renforcer sa supervision. Il serait ainsi possible d'affaiblir les liens entre certains concepts qui ne devraient pas être liés pour garantir une meilleure sécurité dans les réponses. Pour l'équipe d'Anthropic, ce travail ne fait que commencer et leur découverte ne porteporte que sur un échantillon de concepts élaborés par l'IA durant sa formation. Mener une étude à plus grande échelle serait prohibitif en coût de calcul selon les chercheurs. Il faudrait une puissance qui dépasserait largement celle de l'IA. Il reste donc beaucoup à faire pour éviter que ces IA puissent devenir nuisibles dans l'avenir.