au sommaire

Si vous êtes un mordu de science-fiction, vous connaissez sans doute les trois lois de la robotique formulées par l'écrivain Isaac AsimovIsaac Asimov. Si vous ne voyez pas ce dont il s'agit, sachez qu'elles servent à organiser les relations entre les robots et les humains, en obligeant les premiers à ne jamais s'en prendre aux seconds et à toujours respecter leurs ordres, à condition que les consignes données n'entrent pas en contradiction avec la règle de préservation des Hommes.

Nées dans la littérature, ces trois lois inspirent aujourd'hui les scientifiques travaillant dans la robotique. Dans le secteur de l'intelligence artificielleintelligence artificielle par exemple, des voix se sont fait entendre pour réclamer un encadrement plus strict de son développement, en s'inspirant justement des pistes couchées sur papier par Isaac Asimov il y a plus de soixante-dix ans, afin d'éviter que des robots trop capables ne se retournent contre l'humanité.

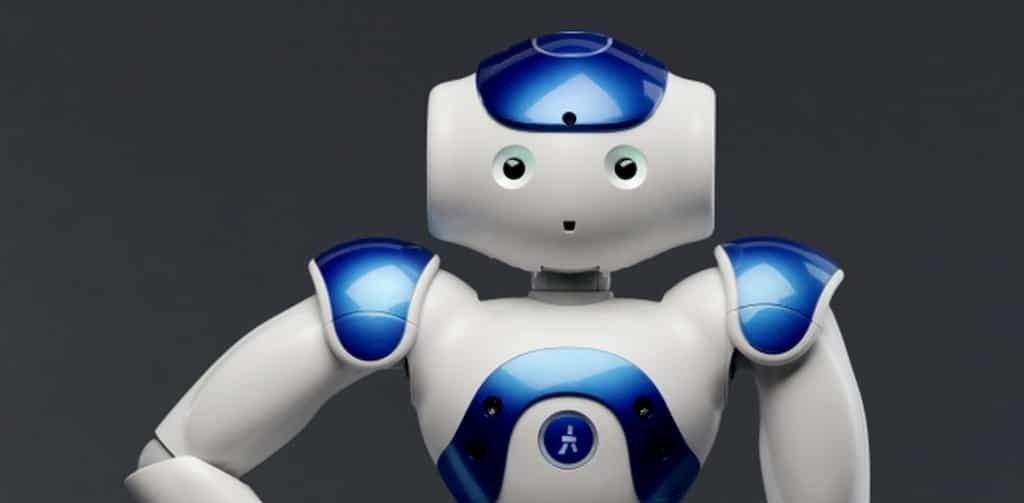

Dans cette démonstration vidéo, l’un des chercheurs de l’université de Tufts a invité le robot Nao à se lever puis à marcher vers le bord de la table. Ce dernier refuse d’abord d’obtempérer car il a détecté la présence du vide et le risque de chute qui pourrait l’endommager. Le chercheur renouvelle sa demande en ajoutant qu’il le rattrapera. Nao accepte alors de s’exécuter. © HRI Laboratory, Tufts University, YouTube

La troisième loi d’Asimov est la plus favorable aux robots

Parmi ces trois lois, l'une est plus favorable aux robots. C'est la troisième. Celle-ci invite en effet le robot à « protéger son existence tant que cette protection n'entre pas en conflit » avec les autres lois. Or les travaux menés par Gordon Briggs et Matthias Scheutz de l'université de Tufts, aux États-Unis, nous font justement penser à cette règle qui invite le robot à préserver son existence.

Utilisant un robot Nao développé par la société Aldebaran Robotics, ils ont fait en sorte que celui-ci puisse rejeter des ordres venant d'un Homme s'ils pouvaient s'avérer dangereux pour lui. Dans l'exemple en vidéo, après plusieurs commandes de base (« assieds-toi », « debout ») l'un des deux chercheurs demande au robot d'avancer droit devant alors que le bord de la table est proche. Le robot explique à ce moment-là qu'il ne peut pas le faire, à cause d'un risque de chute. L'instruction est alors répétée, en précisant qu'il sera rattrapé au moment où il basculera dans le vide.

Cette démonstration, qui en est presque attendrissante quand Nao refuse de se mettre en danger, vise à montrer l'intérêt de permettre à un robot de refuser une consigne afin d'obliger l'opérateur humain à clarifier son instruction. Elle illustre également la constructionconstruction de la déduction du robot, qui prend en compte les informations délivrées par le contrôleur (l'ordre « marche droit devant » a été refusé par le machine face au risque de chute, mais la commande « je te rattraperai » a été dite ensuite).