Voler dans un canyon rocheux étroit au ras du sol, les pilotes chevronnés savent le faire, mais les IA se mélangent les algorithmes entre leur objectif et les contraintes du vol pour l’accomplir. Pour éviter le crash, les scientifiques du Massachusetts Institute of Technology ont créé une méthode innovante autour de l’apprentissage par renforcement.

au sommaire

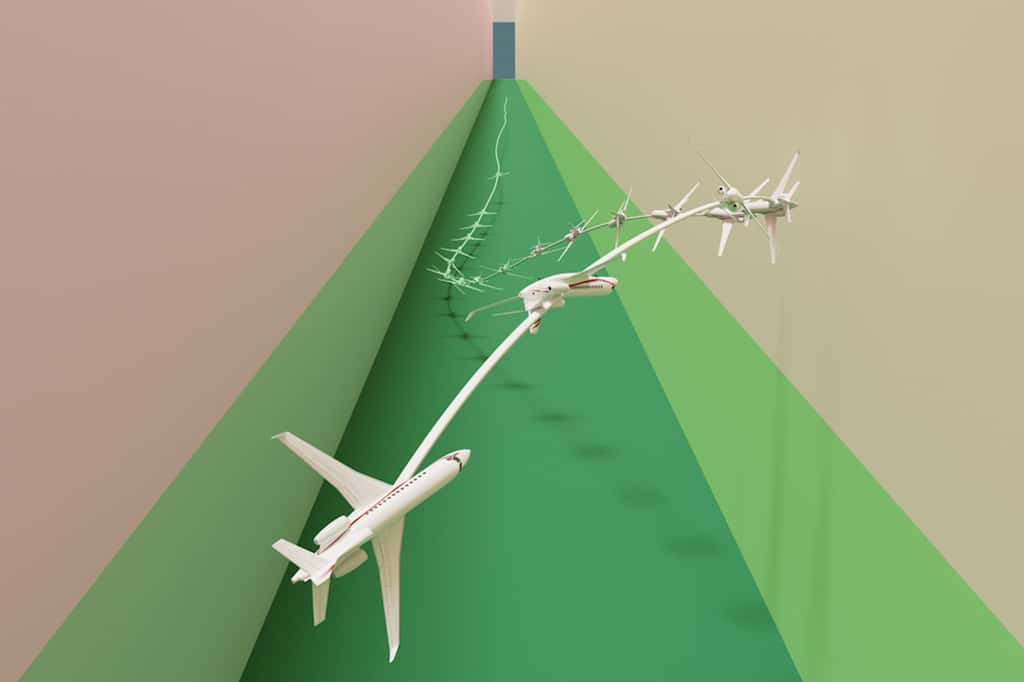

Mine de rien, un véritable pilote aux commandes d’un avion a encore toujours de l'avance sur une intelligence artificielle dans certains cas, et notamment dans des situations périlleuses lorsque l'aéronefaéronef vole à vitessevitesse élevée à proximité d'obstacles. Les appareils pilotés par une IA vont en effet chercher la trajectoire la plus simple et directe vers leur objectif. Or, si celui-ci croise des obstacles, les manœuvres à réaliser entrent en conflit avec ce chemin. Dans cette situation, les différentes IA existantes ne parviennent pas à régler ce type de conflit.

Cela porteporte même l'appellation de « problème de stabilisation-évitement ». Pour contrer cela, les chercheurs du célèbre MIT américain ont mis au point une technique permettant d'assurer à la fois la sécurité du vol et l'accomplissement de la mission par l'intelligence artificielle. C'est encore une fois, des algorithmes d'apprentissage automatique qui ont été exploités pour assurer à la fois la stabilité de l'aéronef et l'évitement des obstacles.

Lors de leurs simulations, à proximité immédiate d'un couloir étroit et en volant à haute vitesse au ras du sol, l'IA s'en est tirée aussi bien qu'un ailier chevronné de Maverick dans Top-Gun. Contrairement aux autres techniques, avec l'apprentissage par renforcement utilisé par le MIT, l'IA apprend de ses erreurs lors des différentes tentatives et obtient une récompense pour tous les comportements qui peuvent lui permettre de se rapprocher de l'objectif de la mission.

Régler les conflits d’une IA pour éviter le crash

Le souci principal est qu'il y a en réalité deux objectifs à accomplir pour l'IA : la mission et sa stabilisation pour y parvenir. Avec l'apprentissage par renforcement, l'IA cherche à trouver un bon équilibre, mais ça lui est très compliqué à jauger. Pour améliorer l'IA, les chercheurs ont séparé la conduite du vol de celle de l'objectif de la mission.

Pour la partie stabilisation-évitement, ils ont créé un nouvel objectif, celui de rester dans certaines contraintes pour pouvoir éviter les obstacles. Il s'agit d'optimiser la conduite du vol face aux obstacles. Ensuite, pour ce qui est de l'objectif de la mission, les scientifiques ont utilisé l’apprentissage par renforcement profond pour que l'intelligence artificielle puisse conjuguer le résultat de l'optimisation sous contrainte avec l'acquisition de la cible. Les chercheurs ont employé des passerelles mathématiques pour que ces deux modules complémentaires puissent se comprendre et se compléter.

Au bout du compte, plus que pour des drones de combat évoluant dans des canyons, cette technique pourrait être déployée pour les systèmes de pilotage automatique des drones de livraison autonomes et même pour les véhicules routiers autonomes. Pour ces derniers, l'IA pourrait permettre d'assurer le maintien de la trajectoire initiale en cas de perte totale de contrôle lors d'un aquaplaning ou une glissade sur une plaque de glace, par exemple.