au sommaire

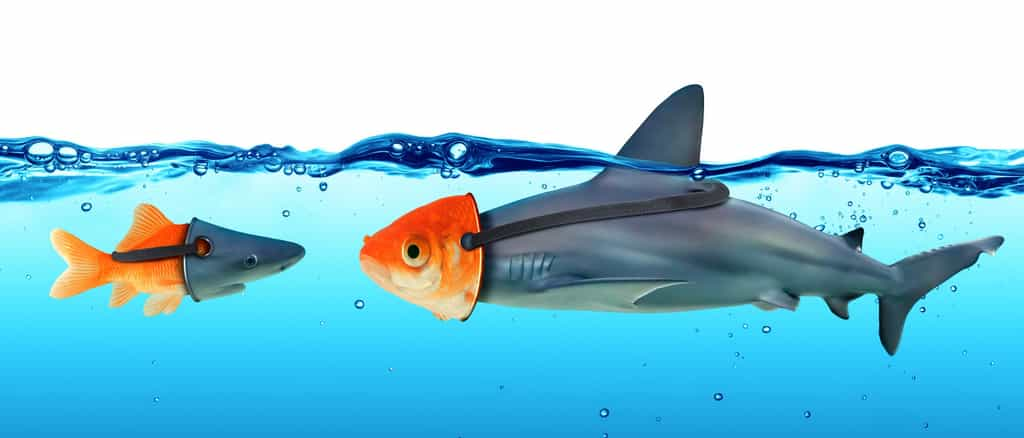

Deepfake. Voici un terme (contraction des termes anglais deep learning (apprentissage profondapprentissage profond) et fake (feint, truqué) actuellement très en vogue qui recouvre une réalité des plus préoccupantes : l'usage de l’intelligence artificielle (IA) pour créer des vidéos truquées qui superposent l'image d'une personne sur celle de quelqu'un d'autre. YouTube regorge d'exemples où l'on voit notamment des chefs d'État tenir des propos qu'ils n'ont jamais tenus. Le deepfake a été aussi exploité dans le porno pour produire de fausses vidéos utilisant le visage de célébrités. Et maintenant, des chercheurs de l'université Carnegie Mellon ont encore perfectionné le procédé.

Ils ont créé des algorithmes qui sont capables de récupérer le contenu d'une vidéo et de l'appliquer à une autre et ce sans altérer le stylestyle de la vidéo cible. La vidéo, ci-dessous, offre une illustration des plus explicites. Cela commence avec le présentateur américain John Oliver dont les expressions faciales et les mouvementsmouvements de bouche sont littéralement calqués de façon transparente sur le visage de son homologue Stephen Colbert. On découvre que le système peut s'appliquer à des fleurs ou des paysages. La démonstration se conclut avec le clonageclonage du style de Martin Luther King appliqué sur le visage de Barack Obama, lequel va ensuite se glisser dans la peau de Donald Trump.

Pour réaliser ce trucage vidéo bluffant, les chercheurs ont créé des réseaux antagonistes génératifs (en anglais, generative adversarial networks ou GANs). Il s'agit de deux algorithmes d'apprentissage non supervisé qui sont mis en compétition l'un contre l'autre. Le premier réseau est un générateurgénérateur qui va créer une copie du style d'une vidéo. Le second réseau est un discriminateur qui examine le contenu produit en le comparant à l'original et évalue sa cohérence. Mais les chercheurs sont allés plus loin en créant un Recycle-GAN, qui analyse les changements visuels non seulement d'un point de vue spatial mais aussi temporel. Cette couche supplémentaire d'informations contribue à réduire les options pour conserver les meilleurs résultats possibles.

La vidéo de démonstration de deepfake réalisée par l’université Carnegie Mellon. © Carnegie Mellon University

Une technique à double tranchant

Pour illustrer la logique de leur technique, ils expliquent qu'elle est analogue dans son principe à celle qui consiste à vérifier la qualité d'une traduction de l'anglais vers l'espagnol en retraduisant le texte espagnol en anglais. On pourra se rassurer quelque peu en sachant que le système est uniquement visuel. Il ne sait pas transposer le son, pour le moment... Mais la performance technique n'en marque pas moins un progrès important dans ce type d'intelligence artificielle.

Le développement du deepfake apparaît inéluctable, sans que l'on puisse totalement le déplorer ou s'en réjouir. Cette technologie est prometteuse, notamment pour l'industrie du cinéma (animations anthropomorphiques, créations artistiques empruntant un certain style visuel) ou pour apprendre aux voitures autonomes comment conduire de nuit ou par mauvais temps. En effet, un GAN pourrait par exemple identifier les dangers dans une scène tournée de jour et les transposer dans des vidéos de nuit.

Mais dans le même temps, elle représente un danger avec des risques de dérives faciles à imaginer : manipulation politique, diffusiondiffusion de fausses informationsfausses informations, vidéos offensantes utilisant le visage de personnes connues ou anonymes (revenge porn). Dans leur article scientifique, les chercheurs de Carnegie Mellon n'éludent pas cet avenir sombre où l'IA permettra de créer des vidéos truquées totalement crédibles. Mais pour eux, maîtriser ces techniques dès à présent donnera les clés pour mieux détecter les tromperies.

Ce qu’il faut

retenir

- Le deepfake est une technique de trucage vidéo qui s’appuie sur l’intelligence artificielle.

- Des chercheurs de l’université Carnegie Mellon ont perfectionné le procédé de sorte à pouvoir transposer le style d’une vidéo à une autre sans altérer sa composition d’origine.