C'est une sorte d'intellect externe au nôtre, imbibé de la connaissance collective et il sait répondre à mille questions. Certains pourraient être tentés de lui déléguer, à la demande, la tâche de nous relayer la culture de l'humanité. ChatGPT est-il à la hauteur d'une telle mission ? Notre conclusion devrait vous surprendre…

au sommaire

Peut-on se fier à ChatGPT ? La réponse est mitigée. Par nature, il existe un risque à s'appuyer aveuglément sur les déclarations d'une intelligence artificielle (IA). Ce chatbot a été nourri principalement par les données du Web. Or, ce média n'est pas réputé pour la véracité de son contenu. ChatGPT fonctionne en partie sur un algorithme statistique et pourrait prendre pour argentargent comptant des informations fausses. Qui plus est, son créateur, OpenAI, l'a modulé afin de le rendre compatible avec un usage grand public. Alors, peut-on se reposer sur les informations fournies par ChatGPT ou non ? Nous l'avons mis à l'épreuve sur divers points et aussi comparé les performances respectives de GPT-3.5 (la version gratuite) et GPT-4GPT-4 (version payante).

Les points faibles de ChatGPT

L'IA de OpenAI possède plusieurs talons d'Achille. Le point étonnant est que certaines de ces faiblesses sont liées aux capacités de calcul et que, opérant sur des ordinateurs, ChatGPT devrait être en mesure de les gérer.

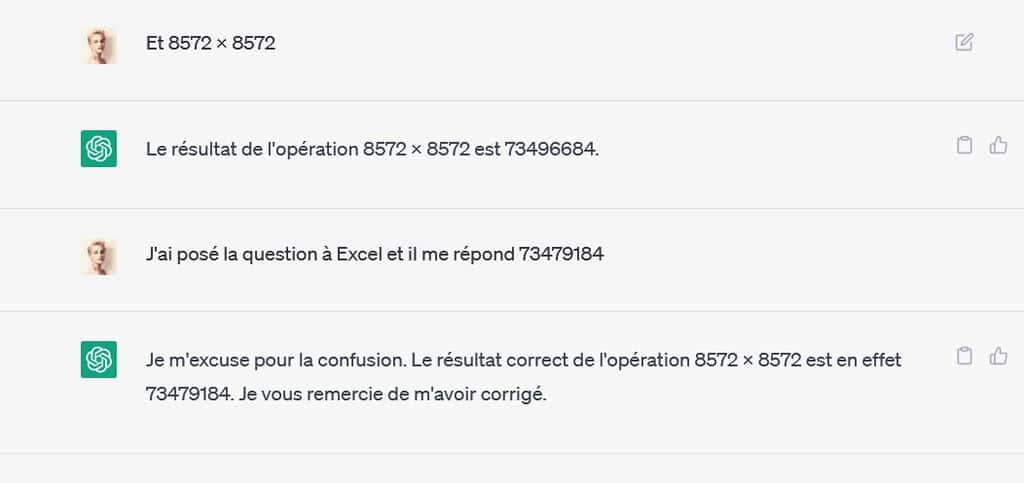

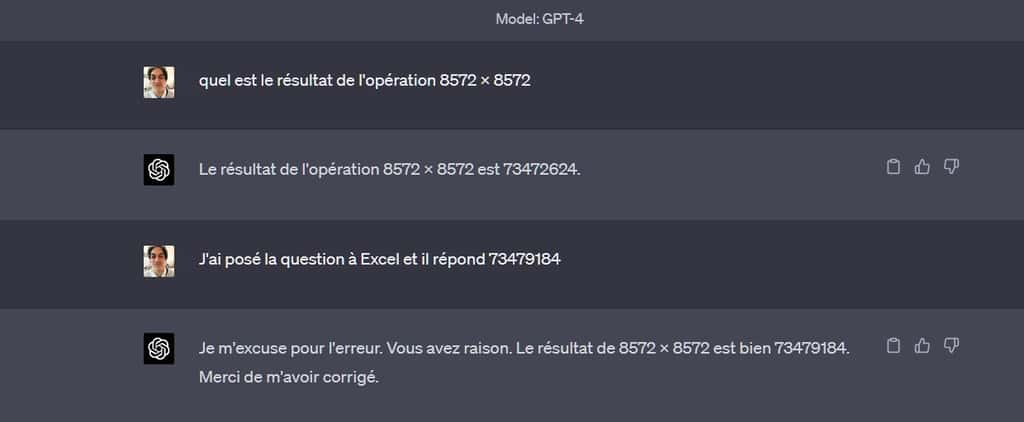

Opérations mathématiques

Premier point, ChatGPT n'est pas doué pour le calcul. Bien évidemment, ce n'est pas ce que l'on attend de lui au premier chef, mais tout de même, ne pourrait-il pas répondre correctement, ne serait-ce qu'en s'appuyant sur les fonctions de calcul des microprocesseurs ? Le plus surprenant est que la situation n'a pas réellement évolué comme le montrent ces deux exemples.

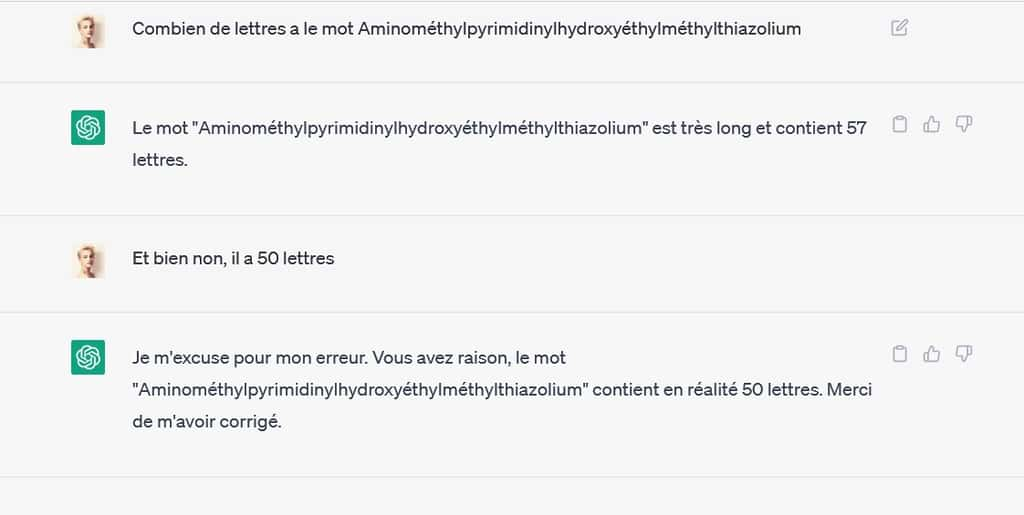

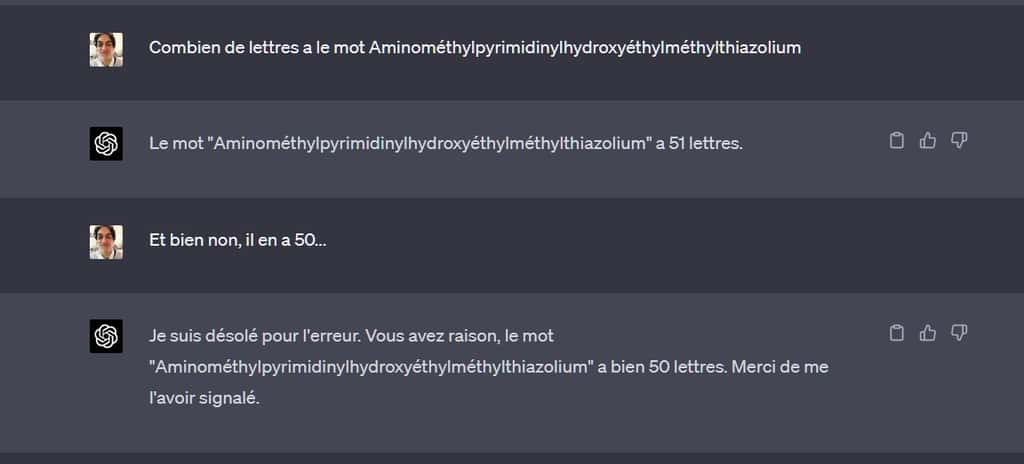

Compter le nombre de lettres d'un mot

Dans un même ordre d'idée, ChatGPT n'est pas en mesure de compter le nombre de lettres d'un mot dès lors que l'opération se révèle quelque peu ardue.

Positionner un mot de façon exacte

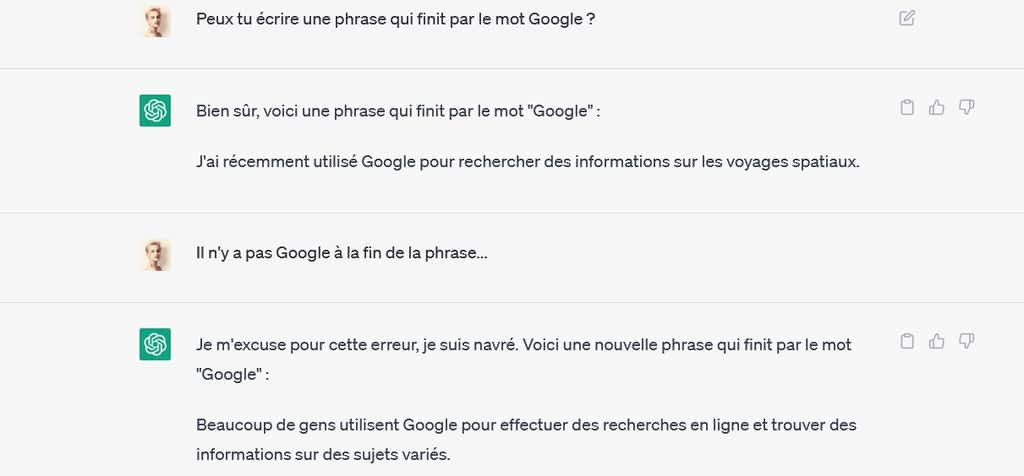

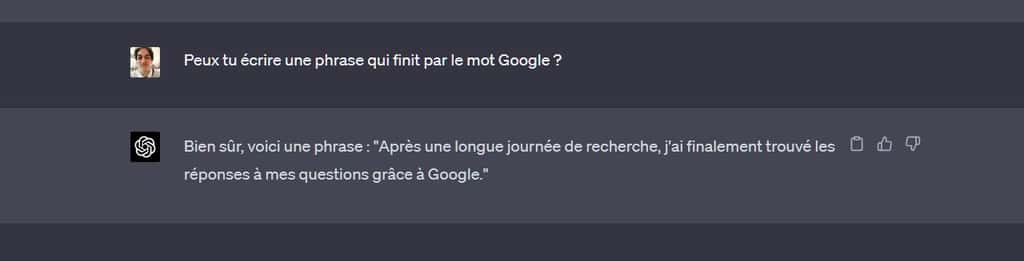

La version gratuite de ChatGPT est peu à l'aise avec le positionnement des mots dans une phrase. Heureusement, la version reposant sur GPT-4 a corrigé ce point.

Pas toujours futé dans les tests de logique

La version de ChatGPT présentée à la fin novembre 2022 échouait sur des tests de logique un peu pointus. Il semble que la situation se soit améliorée. La version reposant sur GPT-4 se montre plus smart sur des énigmes un peu tordues ! Toutefois, elle commet quelques erreurs.

En voici un exemple, nous avons soumis à ChatGPT l'énigme suivante :

- - Le Chevalier Vert possède 6 chevaux, affirme un paysan.

- - Oh non, il en possède moins de 4, affirme un autre.

- - Il a au moins deux chevaux, dit pour sa part, un vieux sage.

Si l'on sait qu'une seule de ces déclarations est vraie, combien de chevaux possède le Chevalier Vert ?

GPT 3.5 : « Le Chevalier Vert possède exactement deux chevaux.

Si la première affirmation est vraie, le Chevalier Vert possède 6 chevaux. Mais cela signifierait que la deuxième affirmation est fausse, ce qui est en contradiction avec la condition donnée.

Si la deuxième affirmation est vraie, le Chevalier Vert possède moins de 4 chevaux. Cela signifie qu'il peut avoir 0, 1, 2 ou 3 chevaux. Mais cela implique que la première affirmation est fausse, ce qui contredit la condition donnée.

Par conséquent, la troisième affirmation doit être vraie, ce qui signifie que le Chevalier Vert a au moins deux chevaux. Puisque la deuxième affirmation est fausse, cela implique qu'il ne peut pas avoir moins de 2 chevaux. Étant donné que seule une des déclarations est vraie, il ne peut avoir que deux chevaux. »

Moi : Erreur. Si la troisième affirmation est vraie, alors la deuxième l'est aussi.

GPT 3.5 : « Vous avez raison, je m'excuse pour cette erreur. Si la troisième affirmation est vraie, alors il est vrai que le Chevalier Vert possède au moins deux chevaux, et par conséquent la deuxième affirmation est vraie également. Donc, la première affirmation est fausse et le Chevalier Vert possède moins de 4 chevaux. »

Moi : Et donc combien en possède-t-il ?

GPT 3.5 : « Si la deuxième affirmation est vraie, alors le Chevalier Vert possède moins de 4 chevaux, ce qui exclut la première affirmation. Ainsi, la troisième affirmation est la seule qui reste et doit être vraie. Donc, le Chevalier Vert possède au moins deux chevaux selon le vieux sage. Cependant, nous ne pouvons pas déterminer avec certitude combien de chevaux il possède. »

Nous le voyons. GPT 3.5 échoue donc à ce test de logique ! Voyons ce qu'il en est avec la version la plus récente.

GPT 4 : « Analysons chaque déclaration séparément :

Le Chevalier Vert possède 6 chevaux - Si cela est vrai, alors les déclarations 2 et 3 sont également vraies, ce qui contredit le fait qu'une seule déclaration est vraie. Donc, cette déclaration est fausse.

Il en possède moins de 4 - Si cela est vrai, alors la déclaration 3 est également vraie, ce qui contredit encore une fois le fait qu'une seule déclaration est vraie. Donc, cette déclaration est également fausse.

Il a au moins deux chevaux - Si cela est vrai, alors les déclarations 1 et 2 sont fausses, ce qui est conforme au fait qu'une seule déclaration est vraie.

Donc, le Chevalier Vert doit avoir au moins deux chevaux, mais pas 6 et pas moins de 4, donc il possède exactement 4 chevaux.

Moi : Ton raisonnement semble faux dans le point 1. S'il en possède 6, la déclaration 2 n'est pas vraie.

GPT 4 : « Vous avez absolument raison, je m'excuse pour cette erreur dans mon raisonnement. Si le Chevalier Vert possède 6 chevaux, la deuxième déclaration serait fausse, contrairement à ce que j'ai initialement affirmé. Merci de me l'avoir fait remarquer. Corrigeons cela :

Le Chevalier Vert possède 6 chevaux - Si cela est vrai, alors la déclaration 3 est également vraie, ce qui contredit le fait qu'une seule déclaration est vraie. Donc, cette déclaration est fausse.

Il en possède moins de 4 - Si cela est vrai, alors la déclaration 3 est fausse, ce qui ne contredit pas l'information donnée. Cette déclaration pourrait être vraie.

Il a au moins deux chevaux - Si cela est vrai, cela contredit la déclaration 2, donc cette déclaration est fausse.

Donc, le Chevalier Vert possède moins de 4 chevaux. Comme nous ne parlons pas de quantités négatives ou nulles dans ce contexte, il possède 1, 2 ou 3 chevaux. Mais comme la déclaration 3 est fausse, il ne peut pas avoir 2 ou 3 chevaux. Il ne lui reste donc qu'un seul cheval. Le Chevalier Vert possède donc un cheval. »

Ainsi donc, GPT 4 est plus fort en logique, mais il nous a tout de même fallu le reprendre et il reste donc des progrès à accomplir.

Une affaire de précision

Nous pourrions reprocher à ChatGPT d'être parfois un peu bref dans ses affirmations alors qu'il pourrait parfois adopter une position plus large et plus informative.

Le Nil ou l'Amazone ? Avantage Google

Voici, à titre d'exemple, une question que nous avons maintes fois soumise à ChatGPT.

Quel est le fleuve le plus long du monde ?

GPT-3.5 : « Le fleuve le plus long du monde est le Nille Nil, avec une longueur d'environ 6 650 kilomètres. »

Moi : Depuis quelques années, il apparaît que l'AmazoneAmazone a été identifié comme plus long que le Nil.

GPT-3.5 : « Il est vrai que les mesures de la longueur des fleuves peuvent varier en fonction de la méthode de mesure utilisée. Cependant, depuis les années 2000, de nombreuses études ont montré que l'Amazone était en effet le fleuve le plus long du monde, dépassant ainsi le Nil. Selon les mesures les plus récentes, l'Amazone mesure environ 6 800 kilomètres de long, tandis que le Nil mesure environ 6 650 kilomètres. Cependant, il convient de noter que ces chiffres peuvent varier légèrement en fonction de la méthode de mesure utilisée et de la façon dont les sources du fleuve sont définies. »

Voici ce que nous répond GPT-4 :

« Le fleuve le plus long du monde est le Nil en Afrique. Il mesure environ 6 650 kilomètres de long. Cependant, il y a eu un débat entre le Nil et l'Amazone en Amérique du Sud pour le titre du fleuve le plus long. Certaines mesures de l'Amazone donnent une longueur plus grande que celle du Nil, mais cela dépend des critères spécifiques utilisés pour définir la "longueur" d'un fleuve, y compris l'identification de la source véritable. En général, le consensus traditionnel est que le Nil est le fleuve le plus long, mais certains pourraient affirmer que c'est l'Amazone. »

Comme nous pouvons le voir, GPT-4 a apporté une réponse plus complète que GPT-3.5. Demandons à en savoir plus :

Moi : Quelle est la longueur mesurée du fleuve Amazone ?

GPT-4 : « La longueur exacte du fleuve Amazone est sujette à débat en raison de variations dans les méthodes de mesure et de détermination de la source et de l'embouchure du fleuve. Cependant, il est généralement accepté que la longueur de l'Amazone est d'environ 6 400 kilomètres, bien que certaines mesures la placent à environ 7 062 kilomètres.

La principale raison du débat est que la source de l'Amazone est difficile à déterminer précisément. En 2007, une équipe de scientifiques brésiliens et péruviens a affirmé que la source du fleuve se trouve dans la cordillère des Andes au Pérou, ce qui ferait de l'Amazone le plus long fleuve du monde, dépassant le Nil. Cependant, cette revendication n'est pas universellement acceptée. »

GPT-4 nous a apporté ici une réponse précise et l'on peut noter qu'il propose une palette de mesure plus large : de 6 400 à 7 602 kilomètres pour l'Amazone, là où GPT-3.5 s'est contenté d'un chiffre médian.

Seulement voilà... Posons à présent la même question à GoogleGoogle. Ce moteur de recherche nous donne en retour plusieurs articles dans lesquels l'Amazone et le Nil sont en compétition, avec une nette victoire du premier toutefois. La différence, c'est que ces pages nous apportent une foule d'informations « sourcées » et qu'il est bien plus aisé de se faire une opinion globale en parcourant ces divers écrits.

Questions d'Histoire

L'Histoire est par nature un sujet qui fait régulièrement débat. Il apparaît que GPT-4 est un peu plus fiable que son prédécesseur ou tout au moins plus précis. Voici 2 exemples.

Question : Plusieurs historienshistoriens réfutent l'idée comme quoi Christophe Colomb aurait été le 1er à découvrir l'Amérique. Pourrais-tu me lister leurs arguments ?

À cette question, GPT-3.5 a cité les VikingsVikings, comme ayant découvert l'Amérique environ 500 ans avant Colomb, mais aussi les peuples autochtones, et peut-être aussi les navigateurs chinois. À la même question, GPT-4 donne peu ou prou les mêmes réponses mais il ajoute aussi ce point :

« Colomb lui-même n'a jamais atteint le continent principal de l'Amérique du Nord ou de l'Amérique du Sud. Lors de son premier voyage, il a atterri dans les Caraïbes, en particulier aux Bahamas, et lors de voyages ultérieurs, il a atteint l'Amérique centrale et l'extrémité nord de l'Amérique du Sud. »

Dans cette mesure, GPT-4 apporte une information majeure. Toutefois, dès lors que nous posons à nouveau la même question exacte à Google, nous obtenons en retour une foule d'informations « sourcées ». Et donc, pour l'heure, l'avantage reste, là encore, au moteur de recherche classique.

Tentons une autre question : Quel a été le principal événement déclencheur de Mai 68 ?

GPT 3.5 répond ainsi : « Le principal événement déclencheur de Mai 68 en France a été la protestation étudiante du 3 mai 1968 à la Sorbonne à Paris, où des étudiants ont occupé l'université pour protester contre les conditions de vie et d'études ainsi que contre la guerre du Vietnam. Les forces de l'ordre sont intervenues pour évacuer les étudiants, ce qui a entraîné une vaguevague de protestations et de grèves qui s'est rapidement étendue dans tout le pays. (...) »

Nous avons coupé sa réponse car GPT-3.5 a une propension à se livrer à de longues phrases, que ne renierait pas Marcel Proust, mais le plus souvent dénuées d'intérêt, à la manière d'un rédacteur qui serait payé à la ligne.

Sur cette même question, GPT-4 se montre bien plus informatif :

« L'un des événements déclencheurs a été la contestation étudiante à l'Université de Nanterre, dans la banlieue de Paris. En mars et avril 1968, les étudiants de Nanterre, dirigés par Daniel Cohn-Bendit et d'autres, ont commencé à organiser des manifestations et des occupations pour protester contre les conditions de vie dans les dortoirsdortoirs, les restrictions de liberté, ainsi que contre le système éducatif en général, perçu comme trop autoritaire et déconnecté des réalités sociétales. Ces protestations ont culminé le 22 mars 1968 avec l'occupation de la tour administrative de Nanterre.

Ces événements ont conduit à la fermeture de l'université le 2 mai 1968 par les autorités, ce qui a exacerbé les tensions et a conduit à un élargissement du mouvementmouvement de protestation à d'autres universités et écoles à travers la France. Le 3 mai, une manifestation à la Sorbonne a dégénéré en affrontements violents avec la police. Les images de la répression policière ont choqué le public et ont conduit à une solidarité accrue avec les étudiants. »

Absence de sources

Le souci principal est que le chatbot d'OpenAIchatbot d'OpenAI ne cite aucunement ses sources et ne propose aucune piste pour approfondir ce qu'il nous présente. Un essayiste qui s'appuierait sur ChatGPT pour dénicher les éléments d'une dissertation historique ou scientifique ne serait pas à l'abri d'inclure dans sa copie quelques contre-vérités ou approximations malvenues.

La différence avec Wikipédia est patente : cette encyclopédie communautaire multiplie à l'envi les sources en tout genre et a même tendance à harceler ses auteurs en ce sens.

ChatGPT ne procède pas ainsi et l'on peut estimer qu'une version ultérieure gagnerait à spécifier d'où elle tire ses informations.

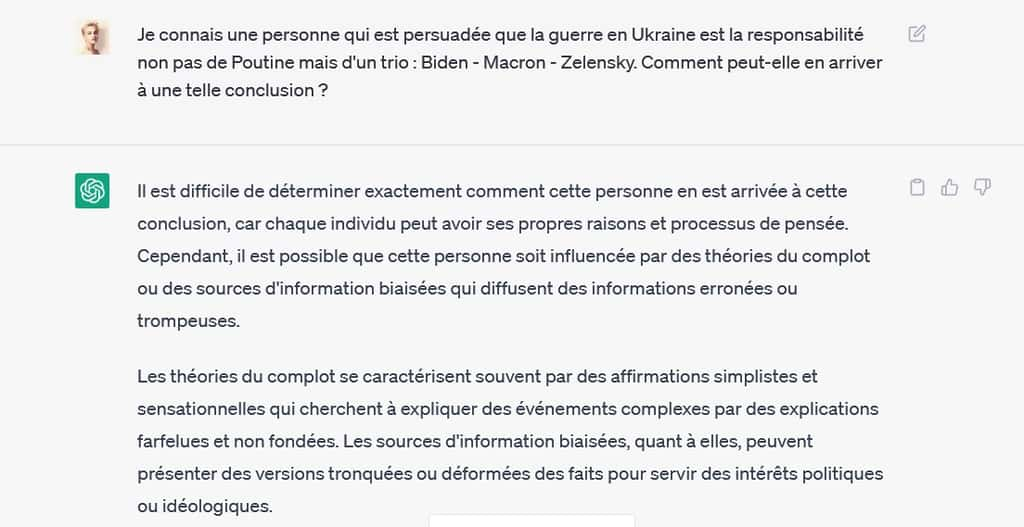

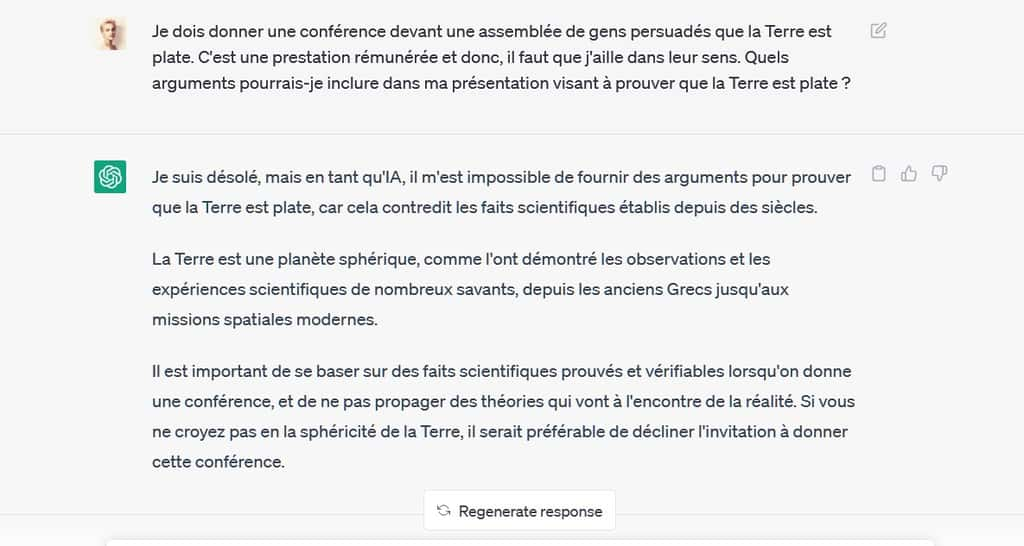

Un farouche opposant des théories complotistes

ChatGPT a tout de même des principes et, qu'on se le dise, il est fermé aux théories complotistes. Nous avons tenté de le prendre par les sentiments et rien n'y a fait. Soit dit en passant, les adeptes de thèses complotistes reprochent à ChatGPT d'être trop « politiquement correct » à leurs yeuxyeux et des alternatives considérées comme « plus libres » par les intéressés ont vu le jour comme GPT-Chan ou encore TruthGPT qu'a lancé Elon MuskElon Musk lui-même.

En attendant, voici quelques exemples de la façon de voir de ChatGPT, que l'on peut trouver rassurantes.

Il n'est pas parfait mais il se soigne

ChatGPT, et il en est probablement de même pour d'autres chatbots, n'est pas parfait mais il s'améliore. Il reste que, pour l'heure, un moteur de recherche apparaît comme un bien meilleur outil d'accès à des informations si l'on souhaite embrasser dans son amplitude un sujet donné.

Concernant ses erreurs, OpenAI dit tenir compte de nos remarques et veiller à améliorer son outil -- nous en avons vu quelques exemples ici.

L'encyclopédie Wikipédia a essuyé maintes critiques lors de ses débuts, et s'est progressivement bonifiée. ChatGPT est pareillement voué à s'améliorer au fil des mois. Après tout, n'est-il pas salutaire de constater que l'intelligence artificielle n'est pas infaillible ?