au sommaire

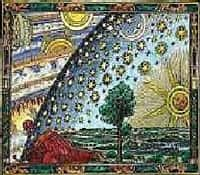

On s'aperçoit que PlanckPlanck fait intervenir l'hypothèse, très laplacienne, que la connaissance de toutes les causes permettrait la prédiction de tous les phénomènes, reléguant aussi les incertitudes d'Heisenberg au rang d'incertitudes provisoires dues à des variables encore inconnues de l'esprit humain. Or, pour Bohr, un démondémon ne pourrait pas savoir, par exemple, la localisation exacte de la particule dans l'expérience de la boîte de de Broglie, car l'indétermination quantique ne provient pas de l'incomplétude de la théorie mais elle en est un des principes fondateurs. Cependant, si la physique quantique est d'essence indéterministe, elle ne l'est pas totalement. En effet, on pourrait dire qu'elle use d'un déterminisme tempéré. Et ceci de deux façons.

La première se rapporte à la loi des grands nombres. Celle-ci induit un "déterminisme statistique" qui se manifeste dans pratiquement toutes les occasions car ce n'est pas à un électron que l'on a affaire mais à des milliards. Cela permet de noyer l'incertitude unitaire dans la probabilité de l'ensemble. La seconde a son origine dans le fait que les lois quantiques ne sont pas toutes indéterministes. En effet, l'équation de Schrödinger, qui est une des formules de base de la mécanique quantique, est parfaitement déterministe. Elle permet de définir avec exactitude les énergies internes des systèmes étudiés ; cela signifie que c'est cette énergie qui est déterminée et non pas l'instant ou le lieu du système. Ainsi, elle représente la possibilité d'amener un vecteur d'état représentatif à prendre la forme : aA + bB. Dans ce cas, l'axiomeaxiome en question fournit les probabilités de trouver la particule soit dans le canal A soit dans le canal Bcanal B. Naturellement, dans le cas où l'expérience est faite non, plus sur une particule mais sur un faisceau en contenant plusieurs millions, la loi des grands nombres vient restaurer une forme de déterminisme. Dans chaque canal on observera, à de petites fluctuations près, un nombre de particules à la probabilité prédite par la théorie ; ici, elle est égale à la moitié dans le canal A et à l'autre moitié dans le canal B. C'est ce que l'on nomme le déterminisme statistique. Cependant, selon l'interprétation de Copenhagueinterprétation de Copenhague, on ne peut aller plus loin dans le déterminisme. Pour elle, les probabilités en question sont intrinsèques, ce qui signifie que même un démon qui, par hypothèse, connaîtrait absolument tout de l'état initial d'une particule donnée et de l'instrument, ne pourrait ni prédire dans quel canal la particule sera trouvée, ni donner les raisons qui font qu'on la trouve dans l'un plutôt que dans l'autre de ces deux canaux. Ainsi, la physique quantique récuse le principe leibnizien de raison suffisante. En effet, selon Leibniz, une connaissance entière des causes suffirait à donner les raisons pour lesquelles un événement se produit, reniant ainsi l'idée de hasard. Or, pour l'école de Copenhague, la physique quantique apporte la preuve que ce déterminisme strict n'est pas viable.

Cependant, cette preuve n'est pas partagée par tous, ce qui se traduit par des théories ayant pour but de sauver le déterminisme classique. Il en va ainsi pour la théorie de l'onde-pilote propre à de Broglie. Elle affirme que la particule et l'onde existent l'une et l'autre simultanément et que la première est pilotée par la seconde. La théorie peut être rendue quantitative et, dans les situations simples, les prévisions essentielles de la mécanique quantique sont retrouvées. Toutefois, elle ne se maintient dans les cas plus complexes qu'à force de modifications la rendant suspecte d'artifices aux yeuxyeux des physiciensphysiciens. L'important ici, c'est que l'indéterminisme que suppose la physique quantique puise sa légitimité dans l'échec des nouvelles théories déterministes car prouver l'indéterminisme ne peut se faire qu'en le déterminant, c'est à dire le limiter à des caractéristiques précises. C'est pourquoi Niels BohrNiels Bohr, et avec lui l'école de Copenhague, affirme qu'on ne peut rien dire de plus que la réalité quantique est indéterminée. Dès lors pour essayer de justifier l'indéterminisme, il faut démontrer l'inadéquation entre la pensée déterministe et le Réel. C'est ainsi que Bernard d'Espagnat montre dans ses divers ouvrages que la probabilité quantique, ou déterminisme statistique, diverge de la probabilité classique. En effet, les énoncés issus de la probabilité quantique n'ont pas pour but de nous exposer les propriétés de l'objet étudié mais celui d'affirmer que si l'on fait sur cet objet la mesure correspondant à la propriété étudiée, on obtient le résultat "oui". La probabilité quantique regroupe l'objet, l'entreprise de mesure et le "on" qui désigne la collectivité des scientifiques. Elle dépend donc de trois variables alors que la probabilité classique ne comprenait que celle de l'objet. Rétablir le déterminisme suppose que l'on puisse fixer avec certitude et en même temps ces trois variables. Or, comme l'expose les incertitudes d'Heisenberg, on ne peut pas différencier l'objet étudié du dispositif de mesure. De même, on peut intégrer à cette interdépendance celle de l'observateur qui, par ses choix, oriente l'expérience. Dès lors, ce que l'on appelle déterminisme statistique c'est l'équation qui conjugue ces trois variables pour établir un résultat. Prétendre que celui-ci est le reflet du Réel qui se présente à travers l'objet, c'est oublier le rôle des deux autres variables que sont l'instrument de mesure et l'observateur. Il en résulte nécessairement que ce résultat est le reflet d'une réalité expérimentale qui a pour but de mesurer le Réel. C'est donc une approche et non l'observation d'une qualité pure de la réalité.

De plus, il ne faut pas limiter ce déterminisme statistique à la seule conjugaison de trois variables car cela signifie que chacune dispose d'une réalité permanente et indépendante. Or, selon l'interprétation de Copenhague, un objet atomique ou subatomique ne jouit pas d'une authentique permanence. Il n'apparaît qu'ici ou là lors d'une mesure, c'est à dire lorsqu'il est détecté par un appareil de dimension macroscopique conçu pour effectuer cette détection. Mais il n'est pas possible, même par la pensée, de lui attribuer une trajectoire, ce qui signifie de l'imaginer occupant à chaque instant un lieu précis, même quand il n'est pas observé. A cela vient s'ajouter le fait que la physique quantique nie le principe de conservation de la matièrematière. En effet, il n'existe aucune sorte de particules dont le nombre reste constant quelles que soient les circonstances. Bernard d'Espagnat précise dans Regards sur la Matière (chapitre 2, 2ème partie), que "toute particule, quel que soit son type -é lectron, nucléonnucléon ou autre - peut éventuellement être créée, en concomitance s'il y a lieu avec son antiparticuleantiparticule, lors d'un choc entre deux, objets subsistants, et aux dépens de la seule énergie de mouvementmouvement de ces deux objets. Et, inversement, une particule et une antiparticule du même type peuvent s'annihiler réciproquement et leur massemasse totalement ou partiellement se transformer en pure énergie de rayonnement ou en mouvement d'autres objets. Le principe de conservation de la matière plaçait le physicien face à un tout limité par des lois qui suggéraient une permanence toujours accessible." La probabilité classique résultait donc d'une ignorance, c'est à dire, schématiquement, que la cause d'un phénomène était soit la raison A soit la raison B, c'est à dire une raison quelconque à déterminer mais qui existait car on avait affaire à un tout limité par des lois comme celles de la causalité. La probabilité quantique expose le choix entre la cause A, la cause B ou pas de cause du tout car le Réel n'est plus conçu comme un tout accessible mais comme un concept qui, s'il existe, nous échappe et nous échappera toujours (ceci si l'on demeure dans le cas de l'interprétation de Copenhague).