Après la révolution quantique basée sur le laser et les semi-conducteurs, une autre se profile de plus en plus clairement à l'horizon avec les technologies et les théories de l'information quantique. On a déjà utilisé un calculateur quantique pour chasser le boson de Brout-Englert-Higgs, et le Cern se penche de plus en plus sérieusement sur les ordinateurs quantiques pour chasser dans un futur proche des particules de matière noire.

au sommaire

Le LHC a été conçu initialement avant tout pour détecter le boson de Brout-Englert-Higgs (BEH) et commencer à étudier ses propriétés. Mais rapidement, il a aussi été question d'y découvrir des particules de matière noirematière noire et, plus précisément, des particules issues des prolongements conformes à la théorie de la supersymétrie du modèle standard de la physique des hautes énergies. Si le bosonboson (BEH) a bien été découvert en 2012, il n'y a toujours aucune trace des particules supersymétriques.

Visite du Cern et ses installations. © Cern

Les physiciensphysiciens et les ingénieurs travaillant au CernCern ne sont nullement désespérés et en mai 2021, le LHC sortira de son sommeilsommeil pendant lequel il a déjà été upgradé pour retourner un peu plus tard à la chasse à une nouvelle physique et aux particules de matière noire, au cours de ce qu'il est convenu d'appeler le « run 3 ». Cette nouvelle campagne de prise de données prendra fin en 2024 et de 2025 et la mi-2027 le plus grand collisionneur d'hadronshadrons du monde terminera sa métamorphosemétamorphose en LHC à haute luminosité, ou HL-LHC. On s'attend à ce que cette machine accumule dix fois plus de données que le LHC au cours de son exploitation. On pourra ainsi déceler des phénomènes excessivement rares et améliorer la précision des mesures sur l'infiniment petit.

Des technologies quantiques variées

Comme toujours, il faudra pouvoir traiter ces données et cela implique de puissants moyens de calculs. Or, nous assistons actuellement au début d'une révolution dont la portée n'est pas encore très claire, celle des ordinateurs quantiques et plus généralement des techniques et des capteurscapteurs relevant d'une « révolution quantique ». Après la première qui s'est exprimée sous la forme des semi-conducteurssemi-conducteurs, du laserlaser et des supraconducteurssupraconducteurs, comme ceux employés pour les Squids, on assiste au début prometteur de la seconde avec l'utilisation de la superposition et de l'intrication quantiqueintrication quantique, ainsi que des progrès dans les techniques de mesures quantiques. Nous n'aurions pas vraiment pu entrer dans le domaine de l'astronomie gravitationnelle sans notamment les travaux du regretté physicien russe Vladimir Braginsky sur la théorie des mesures quantiques (voir son livre Quantum Measurement).

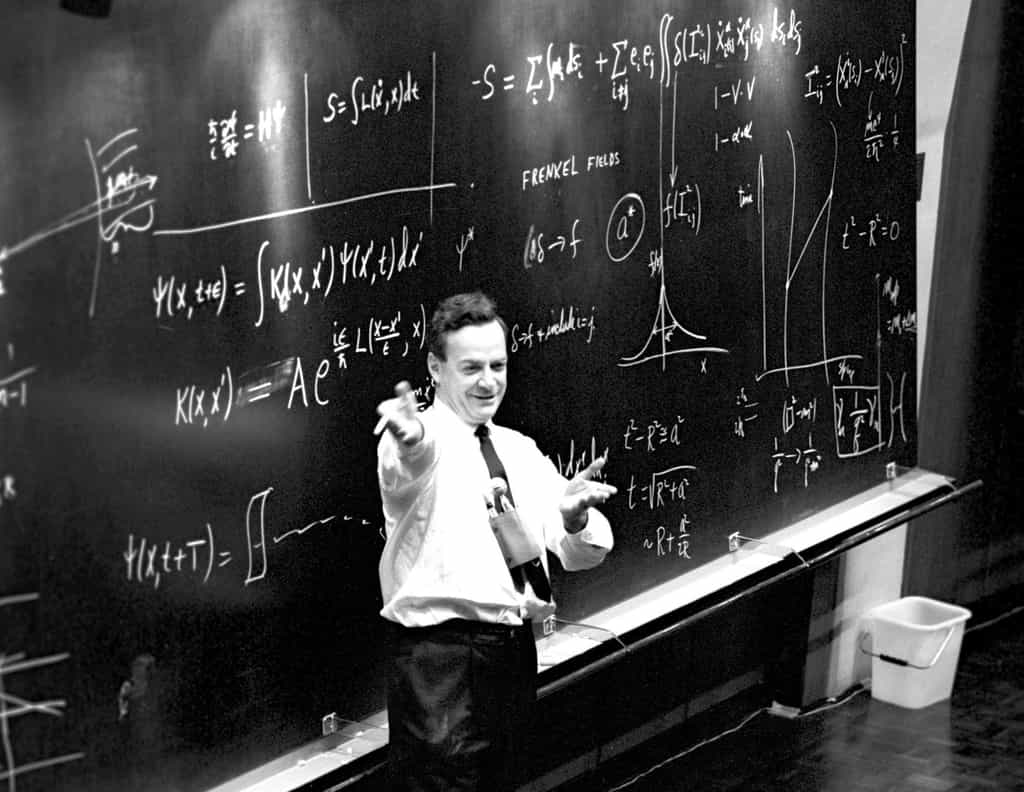

Cette seconde révolution quantique, ce sont probablement les succès, encore timides, rencontrés avec les ordinateursordinateurs quantiques et surtout les simulateurs quantiques comme celui de la société canadienne D-Wave. Suivant en cela les travaux de pionniers de Richard Feynman, on pense en effet qu'il est possible d'utiliser les principes de la mécanique quantiquemécanique quantique pour effectuer certains calculs trop difficiles et trop longs pour simuler le comportement de certains systèmes quantiques avec des ordinateurs classiques. Certains algorithmes dits quantiques, utilisant la généralisation du concept de bits classiques, sont en effet connus pour permettre de résoudre des problèmes intraitables avec les algorithmes classiques connus, même sur des super-ordinateurs.

Du deep learning quantique pour chasser la matière noire ?

Ce n'est pas toujours le cas mais, il y a 3 ans, en utilisant justement le simulateur de D-Wave (dont Futura avait déjà parlé), certains physiciens sont parvenus à redécouvrir le boson BEH dans les données du LHC, mais pas plus vite qu'avec les outils déjà employés. Comme pour des problèmes à N corps en chimie quantique ou en physique du solidesolide, les simulateurs et les ordinateurs quantiques dans un futur proche pourraient bien devenir suffisamment efficaces pour battre leurs ancêtres classiques et permettre de découvrir enfin des particules de matière noire, notamment avec des algorithmes de deep learning.

La plupart des particules qui composent la matière sont instables. Sitôt créées, sitôt désintégrées en d’autres particules. Et sitôt, ici, signifie des temps extrêmement courts, jusqu’à 10 puissance -23 secondes par exemple pour le boson de Higgs. Alors, comment fait-on pour les traquer ? Explications avec Nathalie Besson, physicienne des particules au CEA. Cette vidéo est extraite du jeu Le Prisonnier quantique. © CEA Recherche

Eckhard Elsen, directeur de la recherche et de l'informatique au Cern a tout de même précisé que « L'informatique quantique n'est pas une panacée et ne résoudra certainement pas tous les futurs besoins informatiques de la communauté HEP. Néanmoins, les ordinateurs quantiques commencent à être disponibles ; une percée dans le nombre de qubitsqubits pourrait émerger à tout moment. Repenser fondamentalement nos algorithmes peut apparaître comme un défi intellectuel intéressant aujourd'hui, mais peut s'avérer un avantage majeur pour relever les défis informatiques à l'avenir. ».

C'est donc sans surprise que depuis quelques années déjà le Cern se penche sur les technologies de la seconde révolution quantique comme le rappelle un récent communiqué, mentionné également par la Directrice générale du Cern, Fabiola Gianotti, qui annonçait en juin le lancement d'une initiative Technologie quantique (QTI) au sein du laboratoire européen. Les liens existants déjà dans ce domaine avec GoogleGoogle, IBMIBM et IntelIntel vont donc se resserrer.

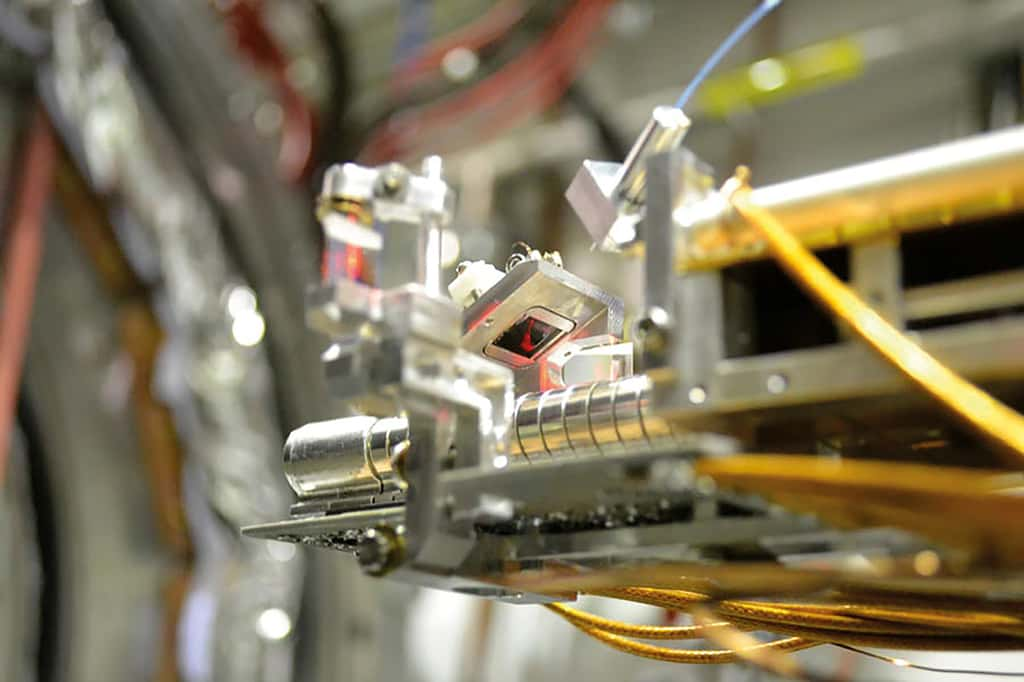

Il faut dire que le Cern dispose déjà de nombreuses compétences dans les domaines permettant d'explorer les technologies quantiques à savoir ceux des capteurs, de la cryogéniecryogénie, de l'électronique et de la science des matériaux. Enfin, le Cern rappelle également dans son communiqué que la collaboration Aegis, sur la piste de l'antigravité, permet également d'étudier l'intrication multi-particules de photonsphotons résultant d'une annihilation du positroniumpositronium, un exemple parmi d'autres d'expériences menées au Cern qui touchent à ces domaines.

La physique du LHC simulée sur ordinateur quantique

Article de Laurent SaccoLaurent Sacco publié le 25/06/2016

En mariant les idées de deux célèbres prix Nobel de physique, Richard FeynmanRichard Feynman et Kenneth Wilson, un groupe de physiciens explore la simulation des phénomènes de la physique des particules à l'aide d'un calculateur quantiquecalculateur quantique. Première victoire : la création virtuelle de paires de particule et d'antiparticuleantiparticule dans le cadre de l'électrodynamique quantiqueélectrodynamique quantique.

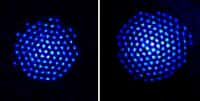

Un groupe de physiciens de l'université d'Innsbruck et de l'institut d'optique quantique et d'information quantique (IQOQI, pour Institute for Quantum Optics and Quantum Information) vient de publier dans le journal Nature un article qui aurait sans aucun doute retenu l'attention du prix Nobel de physique Richard Feynman. Comme les chercheurs l'expliquent dans l'article en libre accès sur arXiv, ils sont parvenus à utiliser un calculateur quantique à base d'ions piégés pour simuler l'électrodynamique quantique dans un universunivers en deux dimensions, une d'espace plus une de temps. Ils ont plus précisément réussi à simuler la création d'une paire d'électronélectron et de positronpositron à partir d'une fluctuation du vide quantique.

CeriseCerise sur le gâteau, en plus de simuler un processus observable au LHC, les physiciens peuvent aussi analyser le comportement de ces particules qui dépend de leur intrication quantique, un phénomène qu'il est difficile d'étudier avec un accélérateur de particules. Bien sûr, rien ne remplace des données expérimentales directes mais pouvoir contrôler les paramètres d'une simulation ouvre la porteporte à la découverte de phénomènes qualitativement nouveaux, difficiles à surprendre et même à deviner.

Les idées de Richard Feynman sur la simulation des phénomènes physiques avec des ordinateurs et des simulateurs quantiques sont certainement le fruit de l'extraordinaire curiosité et créativité intellectuelles qu'avait ce génie de la physique. On peut en avoir une idée avec cette traduction d'une vidéo mise en ligne dans le cadre du projet "The Feynman Series", lié au projet "The Sagan Series" visant à promouvoir l'éducation scientifique pour le grand public. © Bergalion, YouTube

Les théories de jauge sur réseau avec un simulateur quantique

La performance réalisée par les physiciens regroupés en Autriche autour de Rainer Blatt et Peter Zoller s'inscrit en fait dans un cadre plus large, à l'intersection des idées que Richard Feynman a exposées en 1982 dans un article pionnier dans le domaine des ordinateurs quantiques (intitulé Simulating physics with computers) et celle d'un autre prix Nobel de physique, Kenneth Wilson.

Au cours des années 1970, l'essor du modèle standard s'est appuyé sur une classe de théories quantiques des champs, celle des théories de jaugethéories de jauge. Elle fait souvent usage d'équationséquations non-linéaires possédant des groupes de symétrie. Or, comme dans la relativité généralerelativité générale, qui est une classe particulière de théorie de jauge, la non-linéarité de ces équations les rend difficiles à résoudre dans beaucoup de situations physiques intéressantes. Le même problème existe en mécanique des fluides où les solutions trouvées ont consisté soit à étudier des écoulements de maquettes d'objets en soufflerie, soit à mobiliser des ordinateurs. Dans ce dernier cas, il faut discrétiser l'évolution des grandeurs physiques dans l'espace et le temps, comme si cette évolution se produisait sur un réseau cristallinréseau cristallin. Kenneth Wilson a ainsi développé les « théories de jauge sur réseau ». Elles ont eu certains succès, comme de permettre le calcul ab initio, à partir des équations de la chromodynamique quantique (la QCDQCD), de la masse du proton et de celle du neutron.

Feynman, de son côté, a exploré l'idée d'utiliser des systèmes eux-mêmes quantiques pour simuler d'autres systèmes quantiques et plus généralement réaliser des ordinateurs quantiques universels.

Dans cet article de Nature, les physiciens explorent le début d'une nouvelle approche qui à terme permettraient une simulation quantique sur réseau des équations du modèle standard, et pourquoi pas, peut-être dans un avenir plus lointain, de la gravitation quantiquegravitation quantique elle-même.

En l'occurrence, il n'est pour le moment possible que d'utiliser un petit nombre de qubits portés par des ionsions calciumcalcium (quatre pour être précis) et ce pour simuler un processus dépendant du temps dans la plus simple des théories de jauge du modèle standard, celle de l'électrodynamique quantique de Feynman, Tomonaga et Schwinger

Ce qu’il faut

retenir

- Le principe de superposition et le phénomène de l'intrication en mécanique quantique pourraient être utilisés pour faire une nouvelle révolution technologique après celles du laser et des transistors.

- Des calculateurs et des ordinateurs quantiques pourraient se révéler la clé de découvertes majeures dans le domaine de la chimie quantique, de la physique du solide quantique et bien sûr pour chasser une nouvelle physique.

- Le Cern l'a bien compris et il a lancé un programme pour étudier le potentiel des technologies quantiques et les contributions qu'il pourrait y faire.

- Dans un futur proche, la découverte de la matière noire avec le LHC se fera peut-être grâce à ces technologies quantiques de seconde génération.