Le modèle cosmologique standard avec matière et énergie noire est bien vérifié pour un grand nombre d'observations mais il existe tout de même des anomalies et des incertitudes dont on ne sait pas très bien ce qu'elles signifient, une nouvelle physique ou une erreur de mesure ou de calcul ? L'une d'entre elles concerne la formation des amas de galaxies au cours du temps déduite de l'étude du rayonnement fossile dans le domaine des micro-ondes. Les analyses des premières données en rayon X de l'instrument eRosita dans l'espace permettent maintenant d'y voir plus clair à ce sujet.

au sommaire

On parle beaucoup depuis quelques années de ce qui en anglais est appelé « Hubble tension », c'est-à-dire du désaccord entre deux méthodes d'estimations de la fameuse constante de Hubble-Lemaître qui permet de déterminer la distance d'une lointaine galaxie en connaissant son décalage spectral vers le rouge. L'analyse des données du rayonnement fossile (le cosmic microwave background ou CMB en anglais) collectées par la mission PlanckPlanck ne donne pas la même valeur de cette constante que l'analyse des mesures faites avec des supernovaesupernovae SNSN Ia, ces mêmes mesures qui ont permis de découvrir l'accélération depuis quelques milliards d'années de l'expansion du cosmoscosmos observable et d'étudier l'énergie noire.

Depuis un peu moins longtemps, on parle de plus en plus aussi d'un autre désaccord appelé lui « S8 tension », comme le montre le précédent article ci-dessous que Futura avait consacré à ce problème. S8 est un paramètre qui apparaît dans les équations du modèle cosmologique standard et qui est lié à l'évaluation du nombre d'amas de galaxiesamas de galaxies présent dans un volumevolume donné au cours du temps. Ces amas, comme les galaxies elles-mêmes, sont produits par l'effondrementeffondrement de surdensités de matièrematière laissées par le Big BangBig Bang.

L'étude du rayonnement fossilerayonnement fossile donne une estimation de ces surdensités environ 380 000 ans après le Big Bang et en utilisant des simulations numériquesnumériques on peut calculer comment elles vont évoluer pour donner justement le nombre d'amas à une époque donnée. Les mesures semblaient indiquer de plus en plus qu'il y avait moins d'amas que ne le prédisent les simulations numériques, indiquant un problème quelque part, et peut-être la nécessité d'introduire de la nouvelle physiquephysique.

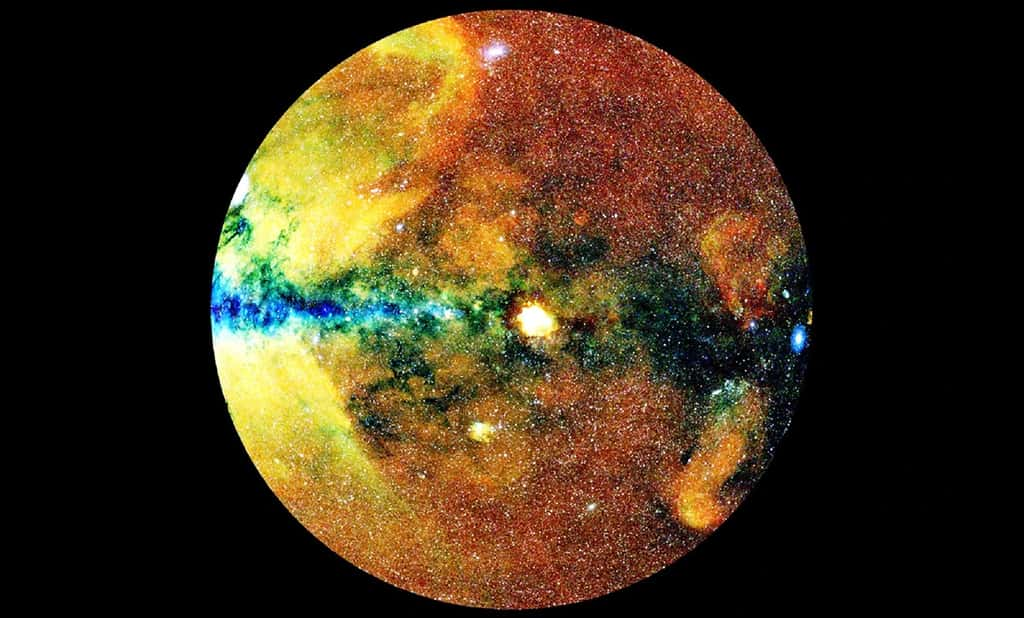

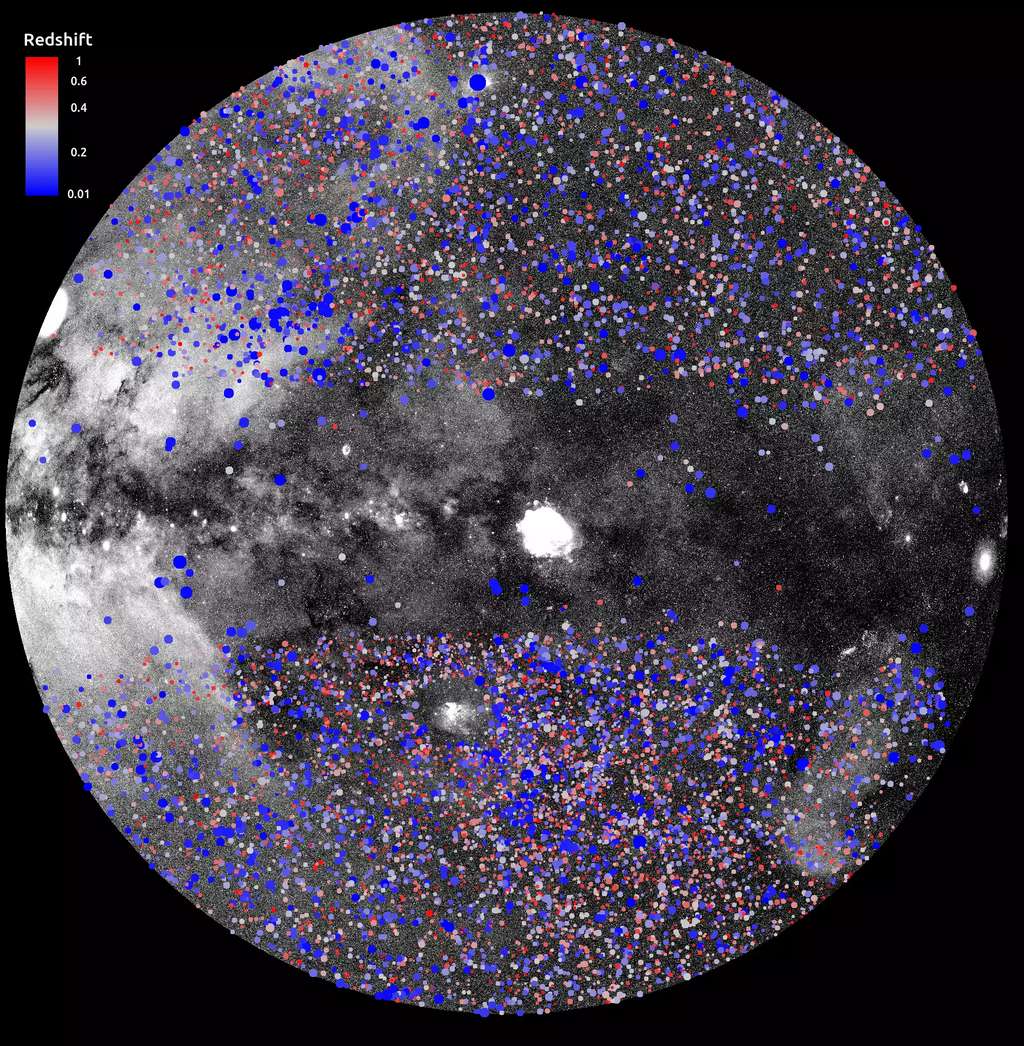

L'instrument à rayons X eRosita de l'observatoire spatial russo-allemand Spektr-RG a capturé des vues époustouflantes du ciel. Cette image montre une moitié du ciel en rayons X, projetée sur un cercle (appelé projection Zenit Equal Area) avec le centre de la Voie lactée à gauche et le plan galactique horizontal. Les photons ont été codés par couleur en fonction de leur énergie (rouge pour les énergies 0,3-0,6 keV, vert pour 0,6-1 keV, bleu pour 1-2,3 keV). © J. Sanders pour la collaboration MPE/eRosita-DE

Un même modèle cosmologique depuis le Big Bang

Plusieurs cosmologistes et astrophysiciensastrophysiciens attendaient donc les résultats des analyses des données en rayons Xrayons X prises par l'instrument allemand eRosita à bord du satellite russe lancé en 2019, Spektr-RG. Un communiqué de l'Institut Max-Planck de physique extraterrestre expliquait déjà qu'en seulement six mois, eRosita avait détecté plus de sources qu'au cours des 60 ans d'histoire de l'astronomie aux rayons X et notamment au cours des grandes missions phares XMM-NewtonXMM-Newton de l'ESAESA et ChandraChandra de la NasaNasa en près de 25 ans d'exploitation.

Les données collectées sur ces seuls six premiers mois à partir de 2019 (la mission s'est poursuivie ensuite) ont permis de dresser un catalogue de plus de 900 000 sources sur la moitié du ciel des rayons X. Ce catalogue contient entre autres pas loin de 710 000 trous noirs supermassifstrous noirs supermassifs et surtout environ 12 000 amas de galaxies dont beaucoup sont nouveaux.

Les membres du consortium eRosita viennent de révéler dans un article déposé sur arXiv ce qu'ils avaient trouvé justement au sujet de la tension S8 en étudiant les amas de galaxies. Ces amas baignent dans un plasma très chaud au point d'émettre des rayons X ainsi que dans un bain de neutrinos produit par le Big Bang. Le modèle cosmologique standard, le Lambda Cold Dark Matter (ΛCDM), postule également que les amas se sont formés dans des concentrations de particules de matière noirematière noire s'effondrant gravitationnellement.

Les données de eRosita posent des contraintes sur la masse des neutrinos dans les amas, le contenu en matière noire en rapport avec le modèle ΛCDM et les abondances de ces amas, c'est-à-dire le paramètre S8.

Dans le communiqué de l'Institut Max-Planck de physique extraterrestre situé à Garching à côté de Munich accompagnant l'article publié, Esra Bulbul, la responsable scientifique principale de l'équipe étudiant les amas et la cosmologiecosmologie avec eRosita explique que « eRosita a désormais amené la mesure de l'évolution des amas en tant qu'outil pour la cosmologie de précision à un niveau supérieur. Les paramètres cosmologiques que nous mesurons à partir des amas de galaxies sont cohérents avec les mesures précises du CMB, montrant que le même modèle cosmologique est valable peu après le Big Bang jusqu'à aujourd'hui ».

En clair, le paramètre S8 mesuré directement avec les amas en utilisant les rayons X est en parfait accord avec les prédictions faites à partir de l'étude du rayonnement fossile. Il n'y a pas de tension S8 selon les chercheurs de eRosita. C’est déjà ce que pensait le cosmologiste français Alain Blanchard et ce qu’il avait dit à Futura dans l’interview au sujet de la mission Euclid qu’il nous avait accordée.

Flamingo, la simulation des galaxies la plus précise confirme un problème de la cosmologie standard

Article de Laurent SaccoLaurent Sacco, publié le 31/10/2023

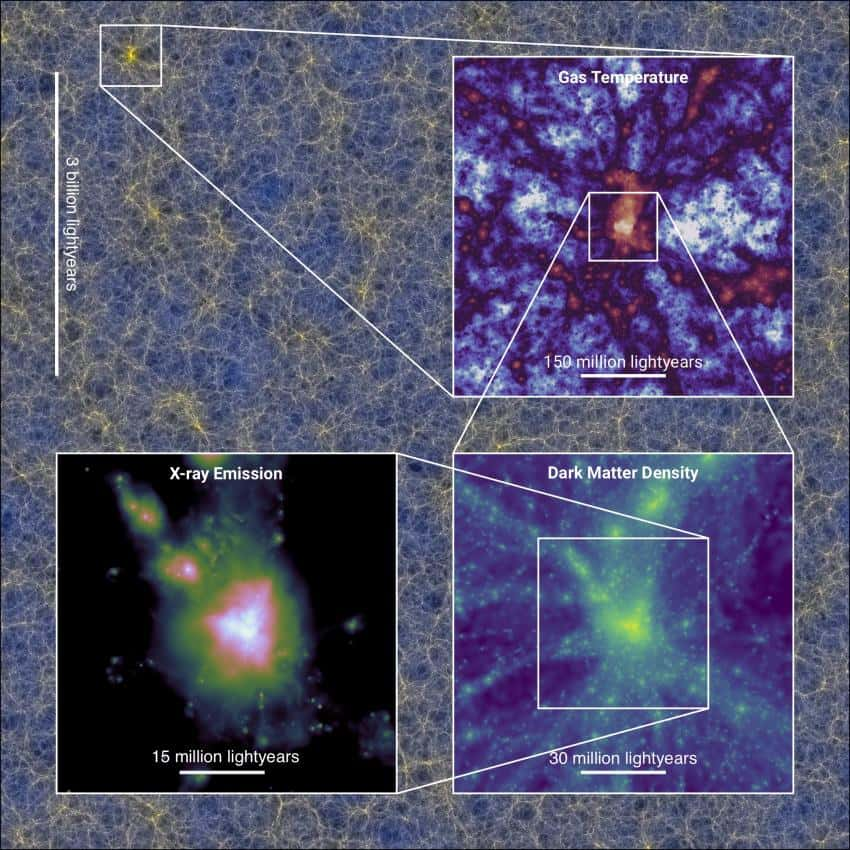

La compréhension de la formation des galaxies et des amas de galaxies ainsi que les grandes structures qui les rassemblent nécessite des simulations numériques de plus en plus savantes et nourries des informations que produisent en massemasse des campagnes d'observations avec des télescopestélescopes au sol ou dans l'espace. La dernière en date, la plus précise et utilisant même l'intelligence artificielleintelligence artificielle, s'appelle Flamingo. L'une de ses conséquences est la confirmation d'un problème découvert avec les prédictions de la cosmologie standard et qui concerne non plus seulement la constante de Hubble mais aussi le taux de formation récent des amas de galaxies. Faudra-t-il introduire de la nouvelle physique ?

Il y a un peu plus d'un siècle, en 1917, Albert EinsteinEinstein proposait le premier modèle cosmologique basé sur la théorie de la relativité généralerelativité générale et c'est au cours des années 1920 à 1930 que Georges LemaîtreGeorges Lemaître va en repousser les limites, anticipant bien des choses qui font partie aujourd'hui des travaux qui concernent le modèle cosmologique standard avec de la matière et de l'énergie noire, allant même jusqu'à pressentir des idées que Hawking et John Wheeler, pour ne citer qu'eux, vont explorer en cosmologie quantique.

Aujourd'hui, avec des programmes d'observations rendus possibles par des instruments comme le satellite Plancksatellite Planck et plus récemment Euclid, nous disposons d'un énorme flot d'observations grandissant et concernant les galaxies, les amas de galaxies et les grandes structures qui les rassemblent. Pour en tirer des informations sur la physique derrière ces structures, et sur leurs naissances elles-mêmes, il faut conduire de puissantes simulations en utilisant des superordinateurs et, tout dernièrement, les outils de l'intelligence artificielle (IA).

L'idée, c'est de voir ce que prédisent les simulations numériques basées sur des équations et certaines observations pour voir si ces simulations prédisent les aspects de l'UniversUnivers aujourd'hui et comment ces aspects ont changé depuis le Big Bang. Cela permet de tester les équations et les théories avancées pour comprendre le cosmos observable, par exemple la nature de la matière noire ou de l'énergie noire, les ordinateursordinateurs pouvant faire des calculs que l'esprit humain ne peut accomplir, en particulier avec des équations non linéaires.

Depuis quelques décennies, des simulations de plus en plus savantes et qui exploitent les progrès concernant les volumes de calculs réalisables ont été conduites, comme la fameuse simulation du Millénaire. Bien de ces célèbres simulations ont été rendues possibles par le consortium VirgoVirgo pour les simulations cosmologiques sur supercalculateurssupercalculateurs qui a été fondé en 1994. Il s'est rapidement développé pour devenir un groupe international de scientifiques au Royaume-Uni, en Allemagne, aux Pays-Bas, au Canada, aux États-Unis et au Japon.

Eagle (Evolution and Assembly of GaLaxies and Their Environments) est une simulation visant à comprendre comment les galaxies se forment et évoluent. Cette vidéo en montrait quelques extraits il y a plusieurs années, basés sur des calculs informatiques modélisant la formation de structures dans un volume cosmologique de 100 mégaparsecs de côté (plus de 300 millions d'années-lumière). Il était suffisamment grand pour contenir 10 000 galaxies de la taille de la Voie lactée ou plus, ce qui permettait une comparaison avec tout le zoo de galaxies visibles dans le champ profond de Hubble par exemple. La simulation démarre alors que l'Univers est encore très uniforme – aucune étoile ni galaxie ne sont encore formées – avec des paramètres cosmologiques motivés par les observations par le satellite Planck du fond diffus cosmologique. Les paramètres cruciaux sont la densité de la matière noire – qui permet la croissance des structures, la matière baryonique – le gaz à partir duquel se forment les étoiles, et la constante cosmologique – responsable de l’accélération cosmique. © Durham University

Des simulations problématiques uniquement avec de la matière noire

Virgo a notamment eu accès à des ressources de calcul intensif de classe mondiale au Royaume-Uni et à l'université de Durham qui a réalisé plusieurs simulations comme celle appelée Eagle (Evolution and Assembly of GaLaxies and Their Environments). Aujourd'hui, avec leurs collègues ailleurs, les chercheurs de cette université ont fait savoir qu'au sein d'une équipe internationale d'astronomesastronomes ils ont été plus loin qu'avec les simulations précédentes en réalisant Flamingo, considérée comme la plus grande simulation informatiquesimulation informatique cosmologique jamais réalisée, utilisant non seulement la matière noire mais aussi la matière ordinaire.

Flamingo est donc un nouvel avataravatar du consortium Virgo dont l'acronyme signifie en anglais cette fois-ci Full-hydro Large-scale structure simulations with All-sky Mapping for the Interpretation of Next Generation Observations. Elle utilise 300 milliards de « particules » ayant la masse d'une petite galaxie dans un volume cubique aux côtés de dix milliards d'années-lumièreannées-lumière de long.

Expliquons le contexte. Selon le modèle cosmologique standard, au sortir du Big Bang, des concentrations de matière noire se seraient effondrées rapidement entraînant avec elles l'effondrement de la matière baryonique ordinaire qui compose les étoilesétoiles, les planètes et bien sûr notre corps. On peut avoir des informations sur les concentrations de matière ordinaire juste au moment de l'émissionémission du rayonnement fossile, ce qui nous donne donc les conditions initiales pour calculer l'évolution de la matière qui va former des galaxies et des amas de galaxies au cours du temps jusqu'à aujourd'hui pendant 13,8 milliards d'années.

Au début des années 1980, la puissance de calcul des ordinateurs est encore rudimentaire dans le domaine de la cosmologie et comme la matière noire est censée dominer en masse et donc par sa force de gravitationforce de gravitation la matière ordinaire, on fait comme si les structures cosmologiques n'étaient formées que de matière noire, ce qui est nettement plus facile et moins gourmand en calcul à simuler numériquement que s'il fallait tenir compte de la matière ordinaire.

Malgré de grands succès, on tombe alors sur plusieurs os, des échecs des prédictions des modèles informatiques basés sur les modèles de matière noire les plus crédibles. L'échec le plus important est sans doute celui de la prédiction de nombreuses galaxies naines autour de grandes galaxies comme la Voie lactée ou Andromède. Elles sont peu nombreuses en réalité.

Des simulations réalistes avec des supernovae et des trous noirs

La solution la plus conservatrice à ce problème, c'est-à-dire sans remettre en cause le modèle standardmodèle standard, consiste à faire des simulations plus complexes tenant compte des explosions de supernovae et de l'accrétionaccrétion de la matière ordinaire par des trous noirs géants, sans oublier bien sûr la gravitégravité des distributions de matière ordinaire. En effet, le souffle des explosions de supernovae en éjectant de la matière ordinaire des galaxies ou les ventsvents produits par le rayonnement des trous noirs avalant de la matière peuvent changer la croissance des galaxies et notamment des galaxies nainesgalaxies naines en éjectant du gazgaz dans le milieu intergalactique. Plus généralement, la force de pressionpression du gaz éjecté peut aussi s'opposer à la contraction gravitationnelle formant des galaxies.

Au cours de la dernière décennie, les progrès en puissance de calcul aidant, on va pouvoir vraiment faire des simulations plus réalistes de la formation et de l'évolution des galaxies en tenant compte de la matière ordinaire. La simulation Flamingo apparaît aujourd'hui comme le dernier sommet de ces tentatives de reproduire l'évolution de l'Univers observable, du Big Bang jusqu'à aujourd'hui. Il en a résulté trois articles publiés dans les Monthly Notices of the Royal Astronomical Society : l'un décrivant les méthodes, un autre présentant les simulations et le troisième examinant dans quelle mesure les simulations reproduisent la structure à grande échelle de l'Univers et les populations de galaxies comme celles qu’explore actuellement le télescope spatial James-Webb.

En faisant varier certains paramètres fondamentaux du modèle cosmologique standard avec matière noire froide dans une simulation, on peut tenter de trouver quels sont les paramètres qui s'ajustent le mieux aux observations. Les cosmologistes ont en particulier fait varier notamment la force des vents galactiques, la masse des neutrinosneutrinos et les principaux paramètres cosmologiques.

On ne connaît pas encore très bien les masses des neutrinos ordinaires, or on sait que les neutrinos par ces masses influent sur la taille des galaxies naines, ce qui est une des manières de comprendre pourquoi il y en a si peu. Comme ils se déplacent rapidement depuis la fin du Big Bang sans entrer dans des réactions avec les autres particules de matière ordinaire, on parle des neutrinos cosmologiques comme d'une petite composante de matière chaude (plus les particules d'un gaz se déplacent vite en moyenne, plus le gaz est chaud et inversement).

Après la tension de Hubble, la tension S8 avec les amas de galaxies

On sait depuis quelque temps qu'il y a une tension en cosmologie entre la manière dont on mesure la vitessevitesse d'expansion de l'espace avec les données du rayonnement fossile, environ 380 000 ans après le Big Bang, et les mesures avec des supernovae depuis quelques milliards d'années. Soit il existe une erreur bien cachée quelque part, soit il faudra faire intervenir une nouvelle physique.

Concrètement, il s'agit d'un désaccord dans les estimations de ce que l'on appelle la constante de Hubble-Lemaître et les Anglo-Saxons parlent à cet égard de la tension de Hubble. Ils parlent de plus en plus aussi de la tension de S8.

De quoi s'agit-il ?

De nouveau, l'étude du rayonnement fossile donne une certaine valeur pour une mesure en quelque sorte de l'importance des amas de galaxie ou, plus précisément, les fluctuations de densité de matière déduite des fluctuations de température et de polarisation du rayonnement fossile nous disent que l'Univers observable devrait évoluer pour donner de nos jours un certain nombre d'amas pour une unité de volume donnée après plus de 10 milliards d'années.

Or, tout comme dans le cas des galaxies naines, le compte n'y est pas, il s'en est moins formé depuis quelques milliards d'années que prévu. La densité d’amas de galaxie peut être étudiée au cours des derniers milliards d’années en observant à quel point ces amas produisent des effets de lentille gravitationnelle faible.

Les simulations conduites avec Flamingo ne rendent pas compte de la plus faible valeur actuelle du paramètre S8 observée par rapport à celle déduite du modèle cosmologique standard. Là aussi, cela pourrait signaler une nouvelle physique, notamment au niveau des particules de matière noire qui pourraient interagir entre elles selon des forces encore inconnues, mais dont on a déjà fait des propositions de modèles théoriques dans le cadre de certaines théories en physique des particules au-delà du modèle standard de la physique des hautes énergies déjà considérée.